最初RNN神经翻译简略笔记

📅 发表于 2017/10/02

🔄 更新于 2017/10/02

👁️ -- 次访问

📝 0 字

⏳ 0 分钟

自然语言处理

#机器翻译

#自然语言处理

#深度学习

只是一个Seq2seq的在机器翻译中的简略笔记

传统翻译是以词为核心一词一词翻译的,这样会切断句子本身的意思,翻译出来也很死板,不像我们人类说的话。

Encoder-Decoder

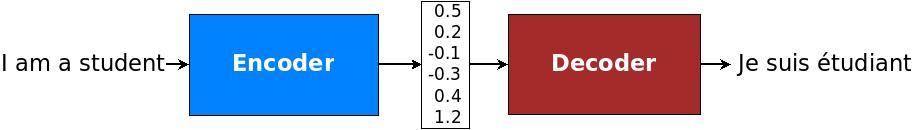

现在采用Encoder-Decoder架构模型。如下图

Encoder会利用整个原始句子生成一个语义向量,Decoder再利用这个向量翻译成其它语言的句子。这样可以把握整个句子的意思、句法结构、性别信息等等。具体框架可以参考Encoder-Decoder框架。

举个翻译的例子,原始句子

Encoder对

Decoder根据语义

当然,在Attention Model 中,Decoder生成Y的时候每个单词对应的

Encoder-Decoder是个创新大杀器,是个通用的计算框架。Encoder和Decoder具体使用什么模型,都可以自己选择。通常有CNN,RNN,BiRNN,GRU,LSTM, Deep LSTM。比如编码CNN-解码RNN, 编码BiRNN-解码Deep LSTM等等。

上面的内容任意组合,只要得到的效果好,就是一个创新,就可以毕业了。(当然别人没有提出过)

有3个维度需要选择。

在本文的实现中,我们选择单向的、多层的、LSTM。基于这篇论文。如下图。