概览内容

开源CodeLLM 发展阶段

阶段1:Encoder 模型

- 聚焦在代码

理解任务,把代码变成向量,做检索任务。 - 主要工作:CodeBert,ERNIE-Code等。

阶段2:生成式 模型

- 从读到写,聚焦在

理解和生成代码。 - 主要工作:CodeT5, CodeGPT等。

阶段3:代码 LLM

大模型,能

写复杂代码、多轮对话式编程、具有指令遵循能力等。代表:StarCoder, CodeLlama, DeepSeek-Coder, CodeQwen等。

阶段4:Agentic 模型

- 通过

MoE来扩展参数+ 提升agentic能力(工具使用、多步推理等)。 - 代表:DeepSeek-Coder-V2、DeepCoder、DeepSWE等。

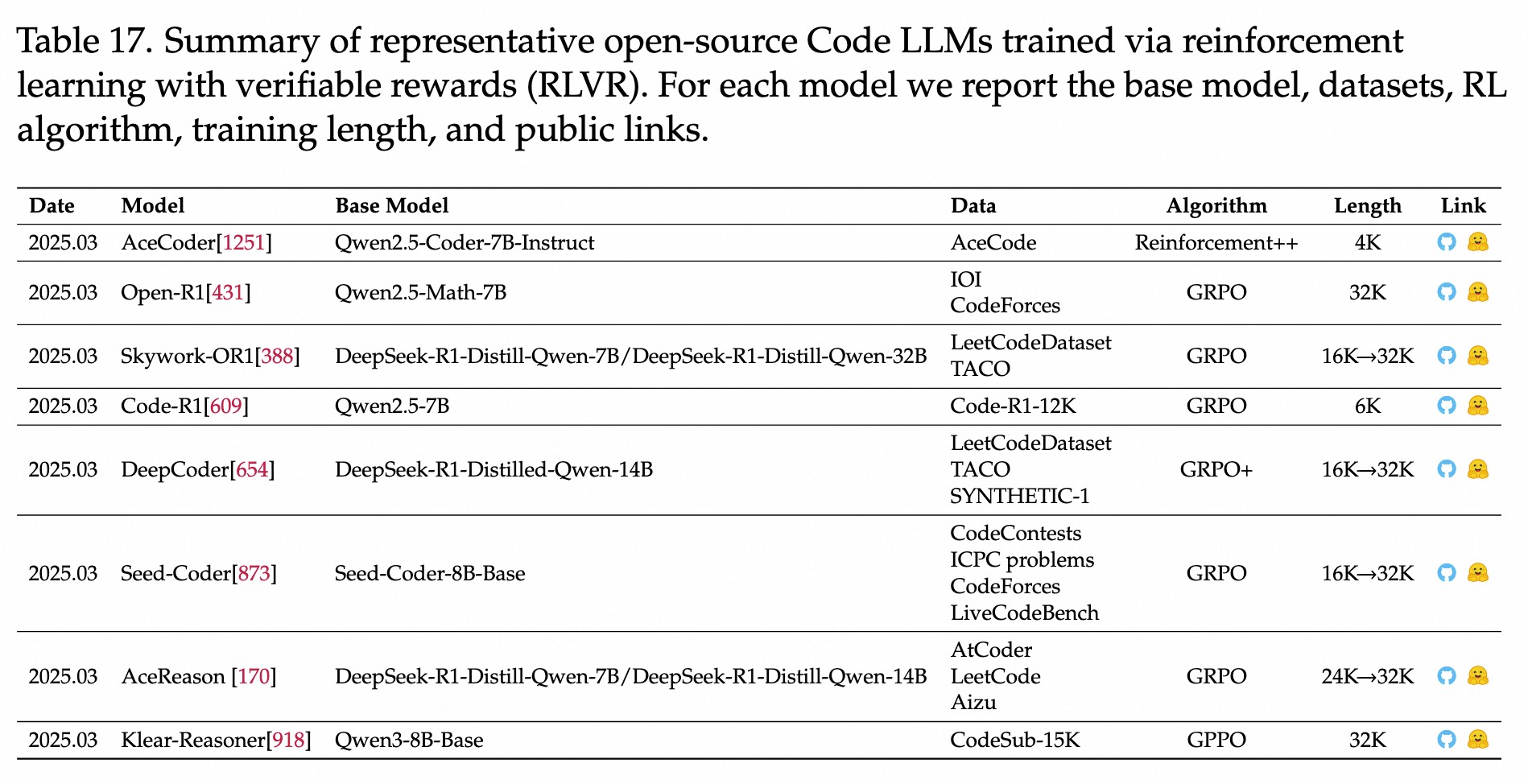

RLVR 后训练相关

(2503) ACECoder

- REINCORCE++ 算法,偏好和二元两种奖励。

(2503) Open-R1

- RoPE:300k 上下文

(2503) Skywork-OR1

- 代码和数学混合训练,多阶段RL,长度从16k -> 32k

(2503) Code-R1

- 12k小数据做微调。

(2503) DeepCoder

- 去掉了KL和熵约束。

(2503) Seed-Coder

- 2阶段:DPO构建指令Instruct模型,PPO创建Reason模型

(2503) AceReason

- 2阶段课程学习:

先数学,再代码。

(2503) Klear-Reasoner

- GPPO算法,保留更多有用的梯度信息,提高梯度利用率,强制模型保持好奇心,缓解了熵坍塌。

(2508) Klear-Reasoner

(2505) Code-R1

(2505) Seed-Coder

(2505) AceReason-Nemotron

(2505) Skywork-OR1

(2503) DeepCoder

参考链接

关键技术

- 基于DS-R1-14B,继续做RLVR训练,目标repo-level代码编辑。

- 训练32k,测试64k。

训练数据

- TACO-verified、LiveCodeBench(23-24)

数据清洗

关键结果

- 完全开源

(2503) OlympicCoder (Open-R1)

(2502) AceCoder

闭源Code LLM

开源Code LLM

阶段4-CodeLLM 列表

(2406) DeepSeek-Coder V1-V2

参考链接

关键技术

- 从DeepSeek-V2继续预训练,对代码和数学继续强化。

- MoE 架构,两个版本:236A21B,16A2.5B。

- YARN:上下文从16k扩展至128K。

训练数据

- 混合数据:代码、数学、文本。数学对编程逻辑重要。6T token。

数据清洗

关键结果

- 效果和高效。

关键技术

从0开始预训练,产出1.3-33B 模型仓库级预训练:- 模拟跨文件的依赖关系,提升对

repo-level的理解和跨文件补全能力。

- 模拟跨文件的依赖关系,提升对

中间填充目标(Fill in the Midddle) +长上下文(16k):- 增强

代码补全和长距离代码推理能力。

- 增强

训练数据

多种编程语言语料库,无私有数据。

数据清洗

关键结果

- 在HumanEval和MBPP上超过 GPT-3.5

- 指令微调版本:

多轮问题解决能力更好

(2510) MiniMax M1/M2

(24,25) DeepSeek V3

参考链接

关键技术

- 整体上:agent能力,混合思考模式,671B激活37B,128k上下文。

- DeepSeek-V3

- MLA+多token预测头,14.8T 预训练,无辅助loss做MoE 负载均衡

- SFT + RL 微调

- DeepSeek-V3.1

- PostTrain:840B语料,上下文由32K扩展至128k,整合DeepThink思维了模式。

- 增强多步工具+code-agent能力,超过v3和r1

- DeepSeek-V3.2

- 基于V3.1-Terminus,使用DSA稀疏注意力,推理成本降低50%,质量和v3.1相当

训练数据

数据清洗

关键结果

(2510) KAT-Dev

参考链接

关键技术

- 基于Qwen3底座。

- 训练pipeline

- Mid-Training:针对工具使用+指令遵循

- SFT:

- RL:代码任务

- 大规模AgentRL:

训练数据

数据清洗

关键结果

- 32B SWE-verified 62.4%

参考链接

关键技术

- 超稀疏MoE:总参数1T,激活32B

- 预训练:MuonClip:解决梯度爆炸不收敛的问题。

- SFT:Agent数据合成技术

- RL:可评估和不可评估任务。

训练数据

数据清洗

关键结果

- 原生工具调用、128k上下文。权重开源。

(2508) GLM 4.5/4.6

参考链接

关键技术

- 架构:A32B,混合推理模式,GQA+QK-Norm+MoE 多token预测头

- Mid-Training

关键数据上采样:仓库级代码+Agent轨迹数据 - 上下文扩展:4k -> 32k -> 128k -> 200k(GLM4.6)

- 后训练:监督学习 + 自蒸馏。

- RL技巧:难度课程、长输出RL、代码加权loss (给代码更高权重)

训练数据

数据清洗

关键结果

- 在TAU-Bench、AIME、SWE-verified、BrowseComp等有较好效果。

- GLM4.6 进一步提升代码、工具使用、agent能力等。

(2507) Qwen3-Coder

参考链接

关键技术

- MoE,

480A35B,上下文256k -> 1M, YaRN。 预训练+所有代码可执行的Code RL训练。

训练数据

- 预训练

- 通用、数学 + 代码, 7.5T tokens (70%)

- 合成数据:利用Qwen2.5-Coder对低质数据做清洗和重写,提升质量。

- RL

- 不仅是竞赛代码,对所有代码做执行驱动的RL。

数据清洗

关键结果

- Agentic Coding、Agentic Browser-Use 和 Agentic Tool-Use 开源SOTA,可与Claude Sonnet4 媲美

(2505) Devstral

参考链接

关键技术

- 目标

repo-scale SWE,多文件推理、长上下文编辑、可验证。 - Devstral-Small (24B, 128k上下文),Devstral-Medium (API)

训练数据

数据清洗

关键结果

- 完全开源。

(2508) DeepSWE

参考链接

关键技术

- 基模:Qwen3-32B + 思考模式

纯RL训练,目标repo-level,可执行和不执行两种验证器。- R2E-Gym环境,rLLM 训练框架

训练数据

- R2E-Gym的子集,4.5k。

数据清洗

- 过滤了和bench相关的数据

关键结果

- SWE-verified:59%

(2503) DeepCoder

参考链接

关键技术

- 基于DS-R1-14B,继续做RLVR训练,目标repo-level代码编辑。

- 训练32k,测试64k。

训练数据

- TACO-verified、LiveCodeBench(23-24)

数据清洗

关键结果

- 完全开源

(2506) Skywork-SWE

参考链接

关键技术

可执行的数据清洗pipeline- 收集

[PR, Isssue]数据,每个issue配一个docker容器 - 让agent去修bug,

仅保留能通过测试用例的轨迹数据。

- 收集

- 高质量可执行SWE 数据 Scale > 模型尺寸 scale

- 效果和数量,呈log对数增长

- 在openhands框架,使用轨迹数据,做微调。

训练数据

数据清洗

关键结果

- SWE-verifed 有较好结果

(2503) Ling-Coder-Lite

参考链接

关键技术

- MoE,top6 路由,改进的NormHead。

共享/常驻专家:shared+routed expertes,DeepSeekV2首创设计。- 训练策略:继续预训练、指令优化(

SFT+DPO)

训练数据

- 指令优化数据:高质量、

可执行、仓库结构数据。

数据清洗

关键结果

- HumanEval, MBPP, LiveCodeBench, BigCodeBench等

阶段3-早期工作

(2411) OpenCoder

参考链接

关键技术

- 完全开源:权重、预测、

RefineCode数据、训练流程 - 1.5B/8B,LLama-Style (RoPE, SwiGLU)

- 两阶段指令微调:

通用SFT、code SFT

训练数据

数据清洗

关键结果

- 8B HumanEval/MBPP效果不错,debug新年超过StarCode2-15B和CodeLLama-7B

(2409) Qwen1.5&2.5 Coder

参考链接

CodeQwen1.5 (7B)

- 关键技术:64k上下文,多种语言训练。GQA提升推理效率。

- 训练数据:代码数据。

- 数据清洗

- 关键结果:较好 bug, SQL, Debug能力。

Qwen2.5-Coder (0.5B-32B)

(2403) Yi-Coder-9B

参考链接

关键技术

- 128k 上下文、52种语言。

- 1.5B、9B。

训练数据

数据清洗

关键结果

- HumanEval, MBPP, LiveCodeBench 和大尺寸模型相当。

(2409) Codestral-22B (Mistral AI)

参考链接

关键技术

- 多种语言,指令跟随。

- 32K上下文,仓库级推理,FIM填充能力。

- 22B模型。

训练数据

数据清洗

关键结果

- 在RepoBench和Python相关评估上,效果不错。

(2405) Granite-Code (IBM)

参考链接

关键技术

- 两阶段训练:

code预训练+混合code文本增强训练。 - 目标:FIM (PSM/SPM)

训练数据

数据清洗

关键结果

(2406) CodeGemma

参考链接

- CodeGemma 2B, 7B

关键技术

代码数据预训练和指令微调。- 训练目标:

FIM且比例更高,支持2种模式- 前缀-后缀-中间(PSM):先给P(prefix),再给S(suffix),猜中间M

- 后缀-前缀-中间(SPM):先给S,再给P,猜中间M。

- 2种尺寸:2B IDE场景-更快;7B chat设计、推理逻辑更强。

训练数据

- 代码数据

数据清洗

- 去重、去污染(去除测试数据)

Multi-file packing:依赖图和单元测试的多文件打包策略。

关键结果

(2403) CodeSheel

参考链接

关键技术

- GPT2(7B) 扩展:8k上下文、GQA、RoPE。

- 数据清洗比简单scaling有效。

训练数据

数据清洗

- 去重、困惑度筛选、结构规则过滤、模型打分。

关键结果

- 优于同类7B模型,在MultiPL-E和代码补全bench上不错。

(23) stable-code-3B

链接

关键技术

- 3B,代码生成和理解,代码补全和text2code。

- 长上下文:16k;

多文件推理。

训练数据

- Github corpora

数据清洗

关键结果

- HumanEval/MBPP 效果不错

(2401) DeepSeek-Coder见下文

(24) MFTCoder

关键技术

- 多任务微调:代码补全、text2code、代码注释、代码翻译、单元测试生成等。

- 多任务平衡方法:数据平衡、token-weighted loss、focal-style强调。

- 效率优化技术:动态padding、packed SFT、PEFT等。

训练数据

数据清洗

关键结果

- 相比于单SFT和简单混合SFT,MFTCoder效果更好,具有泛化能力。

(2308) CodeLLaMA

关键技术

- 基于LLaMA2开发,强调

长上下文、中间填充、代码指令跟随等。- 上下文:RoPE base由

放大至

- 上下文:RoPE base由

训练数据

- 初始化:由LLaMA2权重继续预训练。

- 语料库:

Code-heavy代码语料库 - 特定数据:Python和Instruct版本使用

特定数据集做微调, 强调特定语言和对齐能力。

数据清洗

关键结果

长上下文对repo-level任务有好处。特定语言数据(python)做微调对语言任务有好处。- 经过

安全微调的指令模型降低了毒性。

(2305) CodeGen2

关键技术

- 完整的训练配方:架构选择、采样模式、数据混合等。

- 架构:Casual Decoder就好了。

- 混合训练目标:

NTP(写下文,50% );Span Corruption(补全中间,Infil Train, 填空题, 50%) - 多轮预训练

训练数据

- NL + PL (文本+代码)。

数据清洗

关键结果

- Infil 填空训练,会导致代码生成能力下降(从头写到尾的能力)。

(23) StarCoder 1-2

StarCoder1

- 关键技术:

长上下文+ 中间填充(FIM)训练 - 训练数据

- StarCoderBase:

TheStack(宽松许可代码) - StarCoder:

Python数据定向微调

- StarCoderBase:

- 数据清洗

- 近似去重、benchmark数据去除、个人隐私去除等。

- 关键结果

- benchmark效果好,IDE demo + OpenRAIL_M 许可证。

StarCoder2

- 关键技术

- 2阶段训练:

先训4k学基础语法;再训16k,处理长代码,仓库级上下文。 - FIM 中间填充策略。

- 2阶段训练:

- 训练数据

- TheStack V2:

多种语言issue/PR、docs、数学和逻辑数据。

- TheStack V2:

- 数据清洗

- 关键结果

- 3B/7B/15B模型。

- 3B超过其他同尺寸模型,15B超过更大模型。

(23) CodeGeex

关键技术

- 专注于代码

生成和翻译。 - INT8量化+FastTransformer:显存大幅降低。

- 上线VSCode插件。

训练数据

数据清洗

关键结果

- 推出HUmanEval-X,评估

跨语言翻译能力,包括C++,Java,JavaScript,Go等。

(24) OctoCoder

关键技术

指令跟随模型,基于StarCoder-16B-Base做微调而来。

训练数据

- 使用了

代码提交记录,即包含自然语言和代码。 避免了code-only偏差。

数据清洗

关键结果

- 释放

HumanEvalPack:把HumanEval扩展至代码修复/解释/生成,以及6种语言。 - pass@1效果好,

commit-style数据对bug-fix有好处。

(23) SantaCoder

关键技术

- MQA:提高推理速度

- 两阶段训练方法:先验证设计,再做大规模实验

训练数据

Python,Java,Javascritp等代码数据。

数据清洗

去掉个人信息、近似去重、文档质量过滤等。

关键结果

- 在

多语言code bench(Multi-PL-E)上,优于一些参数更大的模型。

其他架构

Gemini Diffusion / Mercur Coder

- 闭源模型。质量不错,时间大幅降低。

DiffuCoder

- 开源模型,130B训练,与AR模型效果差不多。

- Coupled-GRPO:

- 专门适配扩散模型的RL算法,利用非自回归特性, 引入互补噪声,减少似然估计方差,更好利用探索空间

- 21k RL样本,在EvalPlus上带来4.4%的提升。