SWE 训练工作

(2512) Self-Play SWE-RL (51.4分, Meta)

🌺 论文摘要

参考链接

核心方法

Self-Play SWE-RL框架- 给定

仓库+环境,通过写Bug+修Bug自我博弈联合RL训练。无需人工Issue

- 给定

仓库数据:未知CWM scaffold:bash+search-replace 编辑器

模型效果(CWM-32B-sft)

- 在SWE-V和SWE-Pro上,

SSR方法都超过RL+人类Issue训练的模型,但也没高多少。 SWE-V达51.4分,SWE-P达28.9分。

重要结论

Self-Play RL比Repair/Injection-Only RL性能更好,Inject-Only效果最差。大幅删除代码的Bug更好比仅改一行代码的Bug的好。后者太简单,学习信号弱。- 由于共享1个Policy,

Solver解决率信号对训练效果影响不大。

关键贡献

Self-Play SWE-RL 思想,很有启发意义的工作。

(2511) SkyRL-Agent(39分)

🌺 论文摘要

参考链接

核心方法

SkyRL-Agent 框架:Tool-接口+异步Dispatcher+桥接后端SWE-RL实验:AST工具增强 鼓励检索+增加环境提示信息+On-Policy+留一法优势估计数据:4.5k R2E-Gym,Scaffold:Simple ReAct Agent

模型效果(Qwen3-32B + RL)

纯RL,SWEpass@1 达 39分,相比基模提升15pt。- 超过DeepSWE

36分(报告42分),训练成本降一半。 弱于蒸馏模型SWE-Agent-LM-32B38分。- 泛化性:Terminal-Bench(+2.5%), BrowseComp-Plus(+1.3%), WebArena(+1.2 turns)

重要结论

关键贡献

SKyRL-Agent框架。SkyRL-Agent-SWE 开源实现。

(2511) InfCode(没训练模型)

🌺 论文摘要

参考链接

核心方法

框架:对抗式PatchGeneration+Patch Selection对抗生成代码和单元测试:TestGenerator+CodeGenerator,

没有训练模型。

模型效果

Claude4.5+InfCode:SWE-Verified79.4分。不知尝试了多少次。- 轻微超过

TRAE+DoubaoSeedCode78.8分

重要结论

- 对抗生成贡献4pt,选择贡献8pt。

关键贡献

- 对抗

Bug修复和测试生成的迭代修复框架。 - 虽然没有训练模型,但思路挺好的。

- 后来的

Self-Play SWE-RL就和其思路相同,但区别是使用了RL训练。

(2509) Kimi-Dev(48分)

🌺 论文摘要

参考链接

核心方法

Agentless 训练(3阶段) +SWE-Agent适配(SFT)。Agentless训练:

BugFixer+TestWriterMidTrain:Diff Patch+PR Commit+定位推理合成数据+agent交互合成数据CoT SFT:DeepSeek-R1 蒸馏(SWE-Gym, SWE-bench-extra)CodeEdit RL:执行结果奖励+难度课程学习+正样本强化

SWE-Agent适配:5.7k SWE-smith 轨迹数据 做SFT

训练数据:是不可能开源的。

模型效果(Qwen2.5-72B-Base)

Agentless 训练SWE-verifiedPass@1 48分,TTS(40) 达60分。SWE-Agent SFT适配Pass@1 48分,优于SWE-Agent-LM-32B40.2分;Pass@10达74分,优于AgentlessPass@30 73.8分,推理次数仅1/3。

重要结论

- Agentless训练可以带来

Skill Priors,更好适配SWE-Agent RL的先验最强:做SFT学的快好、做RL效果也更好。

关键贡献

多阶段CodeAgent训练方法论Agentless 训练(MT+SFT+RL) +SWE-Agent适配(SFT)。- 先从Agentless打基础,再逐步做Agent,模型不偏科、适应性强。

(2508) SWE-Swiss(45分)

🌺 论文摘要

参考链接

核心方法

3任务SFT数据构建:问题定位+问题修复+测试生成2阶段训练方法:3任务SFT+2阶段RL 课程学习,难样本:过滤正确率>90的数据。3任务-SFT10k轨迹(蒸馏DSR1),Bug修复-RL12k,来自SWE-Gym,SWE-smith等。TTS方法:EM +GT代码相似度。Scaffold:Agentless,不是Agent

模型效果(Qwen2.5-32B-Instruct, SFT+RL)

- SWE-Verified

SFT达36,RL达45,RL提升9pt,增加TTS(best-120) 达60分。 - 在

通用任务、Math任务、代码生成任务上,均有提升。

重要结论

- 虽然

训练3任务用SFT,但也可用RL做定位,也很有效果,后续可以基于此。

关键贡献

开源数据代码

(2508) NEBIUS SWE-Agent (39分, 筛选SWE-rebench数据)

🌺 论文摘要

参考链接

核心方法

SWE-rebench数据筛选:过滤有误数据+控制复杂度+LLM质量评估+确定性测试数据:7k任务+自蒸馏6.5k轨迹数据+Verified-50做快速验证RFT冷启动:Mask错误格式动作,仅学习有效动作。2阶段RL课程学习65k->131k,7k全部样本->2k难度样本难样本:过滤阶段1正确率 > 2/3、正确率=0的样本

DAPO技巧超长步数惩罚+去掉0优势样本+Token-level Loss,阶段2减小CLIP-Higher步数惩罚:鼓励高效和惩罚死循环动作

Scaffold:SWE-Agent

模型效果 (Qwen2.5-72B-Inst, SFT+2RL)

- 训练后,SWE

pass@1达39分,pass@10达58分,持平DeeepSeek-V3-0324

重要结论

不要过滤超长样本,要惩罚死循环。训推不一致:采样topk, topp导致词表被截断,解法:关闭filter。- 未来难题方向:

长程信用分配问题、盲目自信问题。

(2508) DeepSWE (42分, Agentic)

🌺 论文摘要

参考链接

核心方法

Kubernates R2E环境集群+R2E-Gym 4.5k数据+环境执行反馈GRPO++算法:- DAPO技巧:

Clip-Higher+去除KLloss+去除熵loss+compact过滤 - Dr.GRPO技巧:

优势不除以标准差+去掉序列内Token平均 - RLOO技巧:

留一法计算优势

- DAPO技巧:

Hybrid TTS:执行验证 + 免执行验证SWE-Agent

模型效果(Qwen3-32B, RL)

- Qwen3-32B 经

GRPO++优化后,SWE-verified 达42分,TTS达59分。

重要结论

- 用Claude蒸馏来

SFT模型,SWE仅34分,低于SWE-Agent-LM 40分。 - 用

SWE-Smith和SWE-Gym数据做RL,提升有限。 R2E-Gym很适合做RL,较好课程学习。

关键贡献

- 开源。

(2512) Devstral2(72.2分)

参考链接

模型效果

模型小且效果好256k、Dense模型,比Kimi/DeepSeek都小很多。- Devstral2:

123B,72.2 SWE-verified。 - Devstral Small2:

24B,68 SWE-verified。

- 但

仍落后于闭源模型。

关键结论

- 支持

探索代码库、跨文件协调更改、架构级上下文 - 支持

Mistral Vibe CLI 工具。

(2505) Devstral(46分, tts3指标)

🌺 论文摘要

参考链接

核心方法

- SFT轨迹数据合成方法:基于

环境探索+单元测试验证, 保留正确轨迹- 模式:

CoT+代码执行,OpenHands+SWE-Gym - 具体数据没细讲,类似 DeepSeekV3.2 自蒸馏冷启动

- 模式:

Post-Training方法:简单过滤SFT、严格过滤SFT、RL训练。OpenHands

模型效果

- Devstral-small-24B模型,

SWE达46分,迭代式 Best-of-3指标。

(2502) SWE-RL (Meta)

🌺 论文摘要

参考链接

核心方法

GithubPR数据收集构建方法:仓库事件克隆+PR聚合+预测相关文件+数据过滤- SWE-RL PR数据:

27.3w

- SWE-RL PR数据:

AgentSFT数据合成方法:PR种子筛选+定位数据合成+编辑数据合成- SWE-RL方法:

LLama3-70B+GRPO,不执行环境,采用Patch相似度来做奖励信号 Agentless Scaffold

模型效果(LLaMA3-70B, RL, SWE-Verified)

- LLama3-SWE-RL-70B:

SWE-Verified 41分,在100B模型下效果最好, SFT 达36.2分,效果也不错。未使用闭源LLM蒸馏技术,纯开源数据。

重要结论

RL比SFT效果好。Best-of-N越大越好,但后期逐渐收敛。DenseReward比Sparse Reward好。

(2405) SWE-agent

🌺 论文摘要

参考链接

核心方法

- 设计

Agent-Computer-Interface 范式

模型效果

- 基于

SWE-Agent框架,GPT4-Turbo,SWE-Full-12分,Light-18分 SWE-Agent比标准Shell提高7pt,比RAG提高16pt。

SWE 数据工作

(2601) SWE-Lego (52.6分)

🌺 论文摘要

参考链接

核心方法

SWE-lego数据集:3.2k仓库+32k任务+18k轨迹,来源SWE-rebench数据集构造方法:真实PR+合成任务+Qwen3Coder蒸馏轨迹Refine SFT方法:Mask错误动作+3难度课程学习,难度为交互轮次

模型效果(Qwen3-32B + SFT)

SWE-V达52.6分,TTS-16达58.8分,8B达42.2分。Refine SFT比普通 SFT(48.8分)高 3.8pt没有Git Hacking的结果,让Agent不能查看git log。

重要结论

精细化SFT数据效果可以超过复杂训练方法。

关键贡献

SWE-lego数据集,开源代码

(2510) BugPilot(54.9分)

🌺 论文摘要

参考链接

核心方法

1套Bug合成框架:SWE-Agent开发Feature,引入无意的FeatAdd-Bug数据集-9k轨迹:R2E-Gym+SWE-Smith+FeatAdd轨迹/任务(未开源)2种训练方法:SFT全数据训练,SFT冷启动+RL训练。R2E-Gym 脚手架

模型效果(Qwen3-32B + SFT, SWE-Verified)

BaseMix5.8k-SFTpass@1达49分,即SWE-Gym+SWE-smith蒸馏数据- 增加

FeatAdd-1.2k-轨迹 SFT达51.9分;增加FeatAdd-Bug RL达52.4分。 - 使用

全9k蒸馏数据 SFT达54.9分,高于SWE-Mirror-60k-SFT 52分。14B也达45分。

重要结论

FeatAdd-Bug比较好解决率低(相比规则SWE-Smith),平均修改4.2个文件,Bug类型更均匀。无意Bug比故意Bug效果好。

关键贡献

FeatAdd 无意引入的Bug这种思想- 仅开源模型,并

未开源数据集和代码。

(2509) SWE-Mirror(52分, Seed)

🌺 论文摘要

参考链接

核心方法

1套

SWE任务合成移植方法:任务选择+任务移植+任务验证Bug移植:生成测试用例+生成Bug源代码+生成Issue描述

SWE-mirror-60k 数据:4语言+40 仓库+60k任务+6.3k蒸馏轨迹数据未开源,python为主,来自SWE-Gym,SWE-rebench,Multi-SWE-RL

SFT方法:Mask错误动作Scaffold:OpenHands+MopenHands

模型效果(Qwen2.5-Coder-Instruct-32B + SFT)

- SWE-verified 达

52分。Multi-SWE-Bench-Flash 达21分。

重要结论

Mask错误动作SFT 效果比不Mask或片段剪辑掉的好。- SFT

Data Scaling有效:4k轨迹训练,6->35分;12k训练,达52分。

关键贡献

- SWE-Mirror-60k 任务,没开源,也不算贡献吧。

(2506) Skywork-SWE(36分)

🌺 论文摘要

参考链接

核心方法

SWE任务收集构建方法Repo+PR 收集+统一环境安装+执行验证等。- 基于

真实环境执行来做数据验证,3层增量式镜像(基础+环境+实例镜像)。

Skywork-SWE数据:10k任务+2.5k仓库+8k蒸馏轨迹。没开源数据Scaffold:Openhands

模型效果 (Qwen-2.5-Coder-32B + SFT)

- SWE-verified 达

36分,TTS-3达47分。

重要结论

- SWE

Data-Scaling,Test-Time-Scaling,轮数ScalingLaw 得到验证。 - 经过

单元测试验证的数据比SWE-smith合成数据靠谱,提升6.8%

关键贡献

- 仅开源模型,

未开源代码和数据。

(2505) SWE-rebench

🌺 论文摘要

参考链接

核心方法

自动SWE Issue-PR任务收集工具

关键贡献

- SWE-rebench 数据集:

21k python任务 - SWE-rebench Benchmark 排行榜

(2504) SWE-smith (40分, SWE-Agent-LM)

🌺 论文摘要

参考链接

核心方法

SWE任务合成方法:Agent安装环境+4策略合成候选任务+执行验证+逆向合成IssueSWE-smith数据:128仓库+50k任务+5k蒸馏轨迹SWE-Agent

模型效果 (Qwen2.5-Coder-32B)

- 使用

轨迹数据SFT,SWE-verified 达40,提升33pt。

重要结论

任务Scaling有效,多样性很重要,PR-Mirror,LM-Rewrite的任务比较好。

关键贡献

- 开源代码、

任务、环境、轨迹,真开源! - SWE-smith 52k任务,26k SWE-smith-轨迹,SWE-smith-env

(2504) R2E-Gym(34.4分)

🌺 论文摘要

参考链接

核心方法

自动合成SWE任务方法:Commit挖掘+测试用例生成+反向Issue生成R2E-Gym 数据:10仓库+8k任务+3.3k蒸馏轨迹,R2E-Gym Sub:4.5k 任务OpenHands

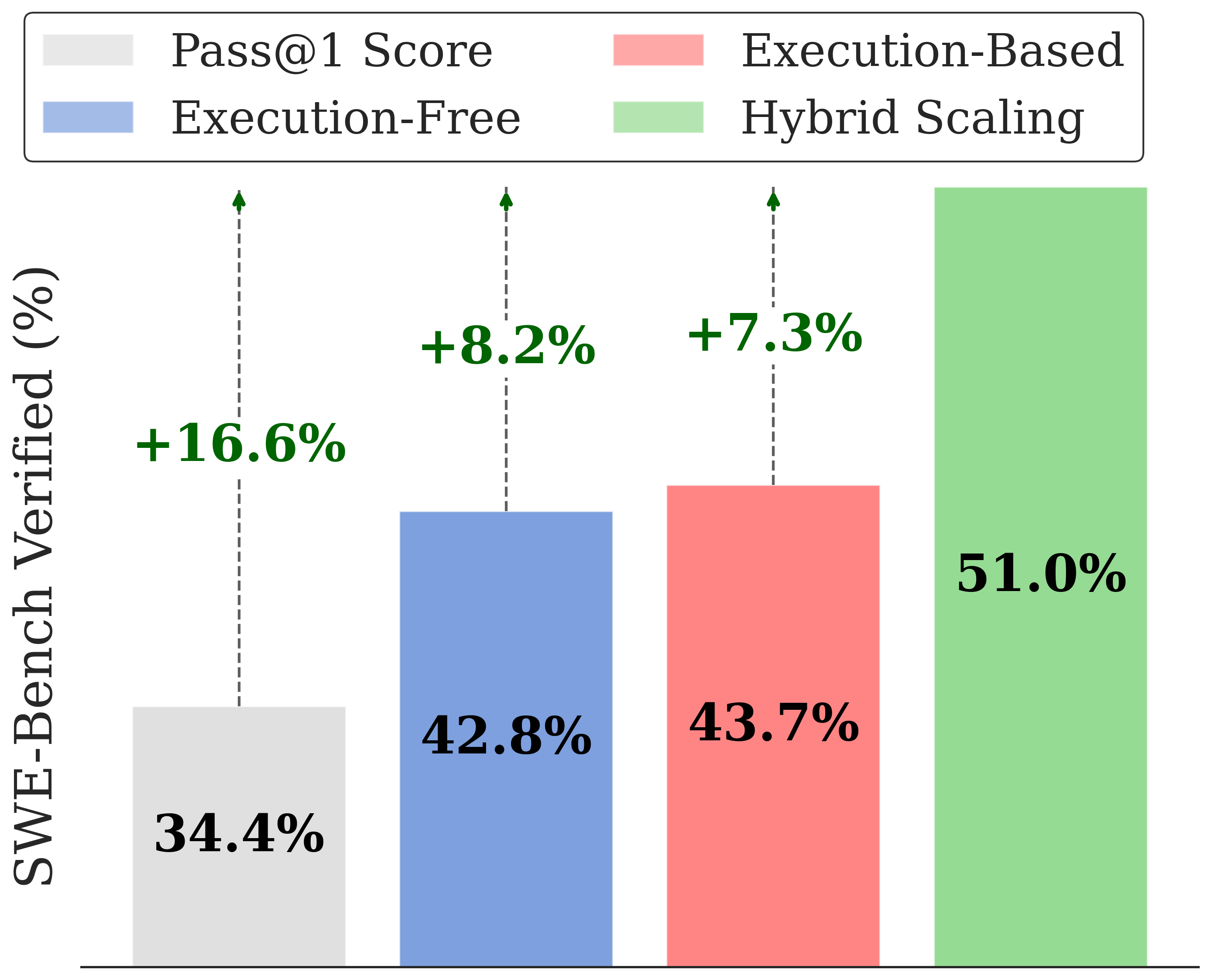

模型效果(Qwen-Coder-32B + SFT)

- SWE-Verified 达

34.4分

重要结论

合成数据不输人工数据Hybrid TTS有效果,从34.4提升至51分。

关键贡献

(2412) SWE-Gym(19.7分)

🌺 论文摘要

参考链接

- 论文笔记, paper, 代码, SWE-Gym Data

核心方法

SWE任务构建方法:通过脚本直接提取PR,并半手动构建好环境(仅覆盖11仓库)SWE-Gym数据集:2.4k任务+11仓库OpenHands,Moatless

模型效果(Qwen2.5-Coder-32B + SFT)

- SWE-Verified

19.7分,TTS-16 达32分。

重要结论

Best-of-16策略:20.6 ->32分,开源模型新标杆。

SWE 背景

SWE 任务

SWE 挑战

挑战

- 环境验证不足:

可执行环境+验证过的单元测试+代码执行套件(统一执行脚本) - 高质量数据不足:

量大质低+质高量小- SWE-Dev:数据多,但缺环境和单元测试

- SWE-Gym:有环境,但仅11仓库

- SWE-Scaling Law 尚不清晰:SWE数据量小,Scaling Law尚未得到验证,增加数据是否带来效果提升?

SWE 存在挑战

Long-Horizon 多轮交互- 2阶段RL,YaRN 技术 扩展至131k

反馈复杂:反馈一大堆报错,可能看不懂- RFT 冷启动

数据难以构建- 对策:使用ReBench做清洗,一套清洗策略

奖励稀疏- 对策:GRPO/DAPO,Token-Level Loss

评估贵且有噪声:跑1次要几分钟,还学不到东西;- 对策:

Verified-50子集、去掉Noisy不稳定数据

- 对策:

TTS 方法

相关笔记

环境执行验证

- 由

LLM生成测试用例,来执行验证,用例通过最多则为最优轨迹。 - 优点:信号直接

- 缺点:

可能区分度低,比如测试用例都太简单、有bug全部都未通过等。

免执行验证

- 不执行验证,通过

LLM来选择最优轨迹。 - 缺点:

容易有偏见,关注Agent的思考过程等,而忽略了代码Patch本身。

混合方法

R2E-Gym 混合方法:

Scaffold(Agent)

Agent ACI 派

核心思想

- 核心:

端到端,多轮推理。迭代plan + act + reflect等。

优点

- 更灵活,扩展性更好。

缺点

- 端到端

难训练,稳定性不如Workflow 交互轮次长,上下文有压力。- RL 训练不稳定

长序列信用分配存在挑战:奖励稀疏- 对

初始模型很敏感,需要SFT冷启动。- 如果从

通用模型开始,可能不会使用工具,陷入死循环。

- 如果从

典型工作

OpenHands

- 提供

编辑器+命令行终端+网页搜索,agent在沙箱环境自主迭代式完成任务。 - 优点:上限高,能处理复杂问题,更像人。

- 缺点:成本高,容易陷入死循环

- 提供

SWE-Agent

- 使用Agent-Computer-Interface,提供

编辑器+shell+测试运行器给LLM。 - 仓库探索、写脚本复现Bug、修复Bug、测试执行、边缘case生成和测试

- 使用Agent-Computer-Interface,提供

Moatless-Tools

AutoCodeRover

SpecRover

Trae-Agent

Workflow 派

优点

流程可控更稳定,模块化更好每一步更容易使用RLVR训练。

缺点

探索空间、灵活性有限。

其他Tradeoff

原子能力可作为skill priors,更好的支持通用Agent。定位、修复、反射、验证等。

典型工作

专有Pipeline- Agentless:固定的

问题定位-Bug修复-执行验证pipeline - Moatless:主张

有效上下文检索才是关键。

- Agentless:固定的

检索微调

- SWE-fixer:由粗到细,文件检索和编辑解耦。

Trade-off 派

先Agentless训练,再适配到SWE-Agent

训练流派

数据蒸馏SFT派 (主流)

- 工作:SWE-fixer,

RL 派 (主流)

- 不执行反馈:SWE-RL

- 执行反馈:主流,但成本高。

进化派

- 在解决问题的过程中,逐渐积累经验,

- 自我提升,Self-Evolution。

- 对抗训练。写Bug-修Bug对抗,写测试-修Bug对抗等等。

- 工作:SE-Agent,