(2512) MiniMax-M2.1

(2510) MiniMax-M2

问题背景

❓问题背景

放弃稀疏注意力的原因

高效(稀疏/线性)注意力目标是节省资源

节省计算资源,同等算力下获得更好性能;而不是在无限算力下超越Full注意力的绝对效果。

现有Bench不全面/评测局限性/观测局限性

旧Bench+小模型上,稀疏能打Full注意力。- 但随着

模型Scale,在复杂/多步推理任务上,稀疏注意力显示出明显缺陷,- 初期没有问题,随着模型训练,在后期才慢慢出现,

非常昂贵的教训

- 初期没有问题,随着模型训练,在后期才慢慢出现,

相比Full,稀疏注意力基建不成熟

- 训练:瓶颈在于

内存访问,需要极致的IO优化。DeepSeek NSA 笔记 - 推理:要实现理论上的速度,需要解决一些工程问题:States的低精度存储、高效Prefix Cache、优化投机解码等。

滑动窗口失败实验

- 改成滑动窗口注意力:发现上下文越长性能下降越明显,因为预训练是Full,

- 按照DeepSeek NativeSA的说法,

需要预训练就是Sparse才行,否则存在预训练微调/训推不一致的问题。

- 按照DeepSeek NativeSA的说法,

Agent后训练对齐目标难确定

问题

- 模型在不同框架里实际效果差异很大。

- 如ClaudeCode里ok,在Roo Code却不ok

- 在ToolUse等Benchmark里ok,实际场景又不ok。

目标1:开源Benchmark

- 衡量

纯粹能力:如BrowseComp。

目标2:适配不同工具

- 模型在不同CodeIDE/Cli、Agent框架等工具里,

都能表现稳定。

Agent 泛化的失败经验

初期Scale想法及问题

- 从最小工具集出发(python+搜索+browse网页浏览),Scale上百种工具。

仅仅Scale Tool_Info

- 问题

- 模型

换个框架(系统指令)、换个环境等,性能就会大幅下降。

- 模型

- 真正的泛化,应该是

全链路的泛化,适应各种扰动信息。

核心方法

📕核心方法

由Linear变回Full Attention

背景

- 当

模型Scale以后,在复杂多步推理任务上,Linear注意力效果不行、低于Full注意力。

核心方法

- 由MiniMax-M1的Hybrid Lighting Attention 改为重新使用 FullAttention

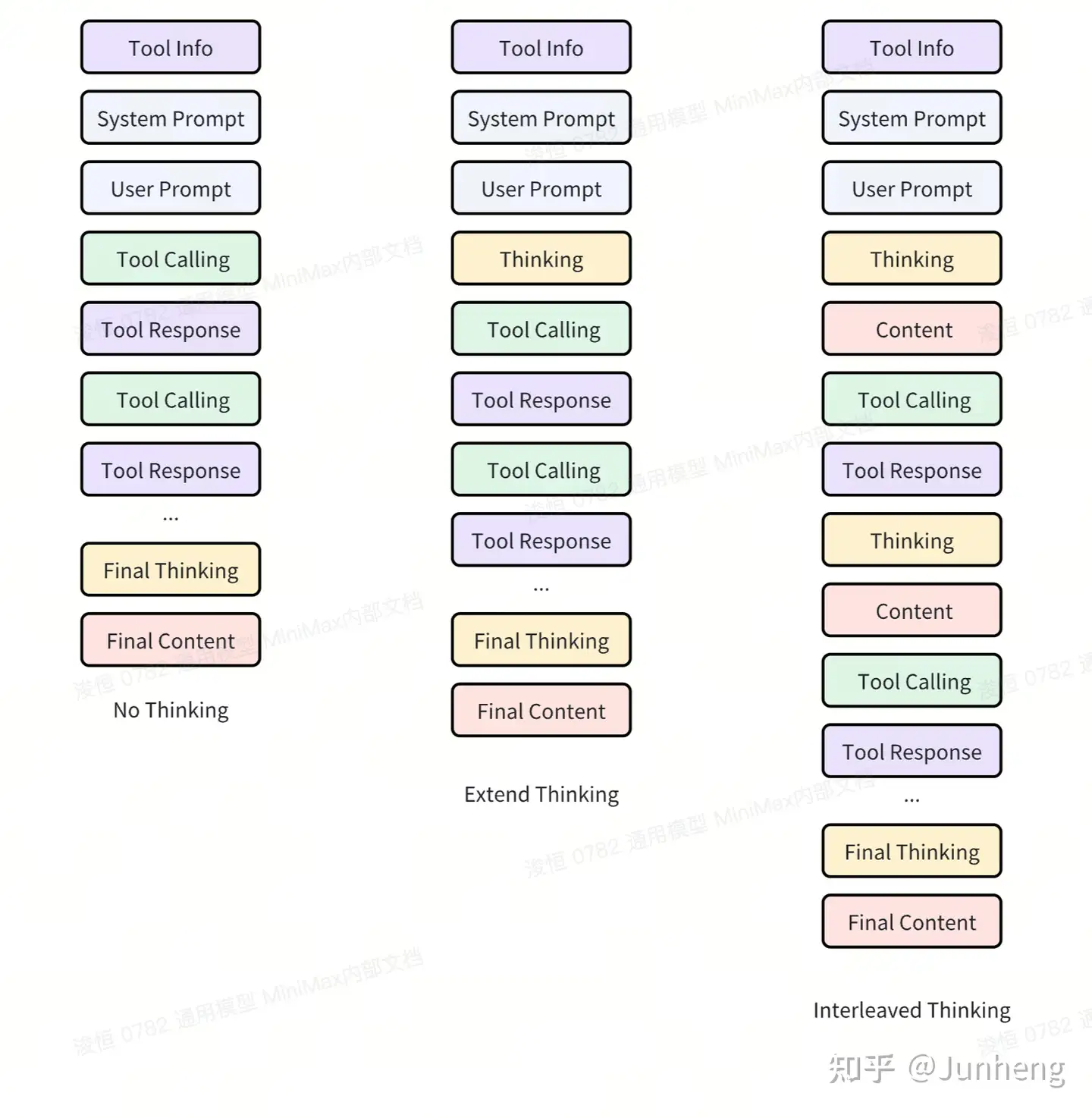

Interleaved Thinking

核心思想

thinking 可以出现在任意位置,而不是推理模型那样只在开头。原因

若只在开头思考,很

难保证长任务的指令遵循Agent加入了模型外的扰动(工具返回内容),要求LLM能

稳定从这些信息中探索到有用的内容。

Interleaved Thinking

- 见下图最右侧。

- 先进行一小步

思考,决定调用工具;调用工具,得到结果;再次进行思考。 思考->行动->思考->行动,直到任务完成。

特点

- 需

保留完整上下文,包括中间所有的thinking内容。

Agent 全链路泛化

背景

- 泛化

不仅仅对Tool_Info做Scaling,而需要对全链路做泛化,应对所有环节变化。

全链路泛化

- 系统指令扰动:

System Prompt,不同框架可能不同, - 用户指令扰动:

User Prompt,用户提问可能模糊、不完整。 - 环境扰动:

Env,代码仓库文件结构可能是混乱的。 - 工具返回扰动:

Tool Response,同一个错误,不同工具返回可能不一样。

核心方法

- 覆盖全轨迹泛化的数据链路,人工制造出各种环境的扰动数据,来训练模型。

优点

- 提高模型

抗扰动能力,保证在绝大扰动情况下,都能稳定的完成任务。 - 结果超出预期。

Good Reasoning 数据

质量必须高

- CoT:

逻辑完整、无冗余。- 比如:过于简单的CoT会让模型不思考或过于自信。

- Response:

多样性要好、不同格式,- 不过拟合在一个固定bench格式上

- 数据必须干净:

过滤幻觉、逻辑错误、指令不跟随等数据- 清洗方法:

Rule+LLM-as-a-judge方法,。

- 清洗方法:

数据多样性和难度

math和code是推理能力的基础:能给其他任务带来收益。- 需要

足够多样的领域数据:逻辑推理、科学知识、指令跟随、开放创意等。 数据要有难度:更难的、更复杂的query,对模型训练更有效。需调整数据分布:- 根据

passrate(可验证数据)、复杂度评分(不可验证)来做调整。

- 根据

数据Scaling

- 当

数据质量和多样性都过关时,就进入大力出奇迹阶段,提升数据规模,带来效果增益。 - 常见手段

增加query数量,1Q多A,多epoch训练,混合不同方向的数据,带来更多的训练步数

- 工业数据Scale Pipeline

- 高效生产

海量、高质量、多样化的数据。 - 把数据分为2类,建立2条pipeline,

自动化数据合成和处理。- 可验证:数学/code

- 不可验证:开放性的,无唯一答案的。

- 高效生产

复合能力

- 如 知识+Reasoning,Agent工具对Reasoning任务的增益。

融合可验证和不可验证2类任务

- 不同doman CoT融合、训练方式统一等。

✍️实验设置

🍑关键结果

⛳未来方向

(2506) MiniMax-M1: Scaling Test-Time Compute Efficiently with Lightning Attention

- MiniMax-M1 Paper, 2025 LLM 技术报告(8):MiniMax-M1

- 在MiniMax-Text-01上,

扩展RL训练(CPT/SFT/RL),提出了CiSPO算法。 - 核心:RL训练中,

可验证任务和不可验证任务的数据构建及训练策略,以及长度Scaling。

问题背景

❓问题背景

MiniMax-Text-01

Hybrid Lightning Attention+MoE

LRM

- LRM很好,但

扩充长度受限于softmax限制。 - 有些解决方法,但都

没在LRM上大规模应用。

冷启动训练

继续预训练

背景

- 提升基座模型推理和长上下文能力,

推理相关数据预训练,保持多样性。

训练数据

- 7.5T tokens:精心挑选的

推理相关语料。 - 用真实自然的

Web和PDF数据,不用人工合成数据。 - 提高数学、代码数据召回率,

整体达70%比例。包括STEM、Code、Book、推理数据等。

训练策略

- 降低MoE辅助loss系数、调整并行策略支持

更大的micro_batch_size。 - 学习率

- 2.5T tokens:

8e-5 - 5T tokens:

衰减至8e-6

- 2.5T tokens:

上下文扩展

- 背景:Hybrid注意力,激进扩展上下文,容易出现梯度爆炸。

- 原因:早期层优化跟不上后期层的变化。

- 方法:

- Earlier Layers和Later Layers有

不同的衰减率。 - 四阶段训练方法:从32k开始,逐步扩展至1M token。

- Earlier Layers和Later Layers有

SFT

背景

- 通过高质量示例,向模型慢慢注入类似于反思、CoT之类的预期行为。

- RL 冷启动。

训练数据

- 领域:数学、代码、STEM、写作、QA、多轮对话。

- 数学、代码占比60%

RL 训练

📕核心方法

CISPO算法

- CISPO 算法:放弃信任域、只裁剪IS权重数值,使用Token-Level-Loss

可验证数据

1. 数学推理

- 数据源:公开、数学竞赛等,数十万高质量,覆盖多种难度,每个都有参考答案。

- 清洗流程

- 过滤

- 不完整的、格式错误、排版错误

多个子问题的、证明题的、二元选择题(避免蒙)- 不能从参考答案中提取出最终答案的

- 使用

强推理模型做预测,计算pass@10,过滤得分超过0.9的样本

- 去重

SFT去重:基于embedding的方法Benchmark去重:基于embedding+ngram的方法

- 重写

- 多选

改写为开放式问题

- 多选

- 答案提取:利用模型从参考答案中提取出最终答案

- 过滤

- 结果:

50k高质量数学数据

2. 逻辑推理

- 数据源:挑选

41个logic推理任务(密码破译、数独等) - SynLogic:合成了

53k逻辑推理数据。- 2大核心:

Task-specific generator+rule-based task-specific verifiers。 - 配置难度系数

- 避免过难数据:要求

pass@10 > 0 - 难度下限:MiniMax-Text-01:通过率在0-0.5之间。

- 避免过难数据:要求

在训练后期,逐步增加难度。

- 2大核心:

3. 竞赛编程

- 数据源:公开竞赛平台、网站。

- 对于无测试用例的:

使用MiniMax-Text-01生成测试用例- 和推理一致,根据质量和难度筛选问题,仅

保留中等和较难问题。

- 最终:

3w竞赛编程数据。

4. 软件工程

- 基于github的真实数据,筛选了

几k。- 包括PR + Issue。(bug定位、代码修复等)

- 有预定义的测试用例,也可以生成测试用例。

- 每条数据:

问题描述、初始错误代码、一组测试用例。

- 类似

SWE-Bench,构建可验证的RL环境,沙盒环境- 代码可执行

- 正反馈:

编译成功、测试用例通过 - 负反馈:编译失败、测试用例不通过等等

不可验证数据

总计

- 25k 复杂样本

有GT 任务

STEM及其他事实性问题,有客观gt但表达多样,不好通过rule验证Generative Reward Model,5分制,评估2部分- RM Benchmark(人工标注的):

(模型回复,gt) Best-of-N和Pass@N的差距- 逐步调优

GenRM的prompt。

- RM Benchmark(人工标注的):

无GT 任务

- 从内部标签系统抽样的数据,包括指令跟随、创意写作等。

- 确保多样性,覆盖多个领域。

- 参考答案生成:使用内部/外部模型,生成参考答案。

- 奖励信号:

模型回复和参考答案做比较。-1:更差,0:差不多;1:更好

训练策略

LongCoT GenRM 长度偏差 / Reward Hacking

偏爱冗长回复,且无实质内容,- 不爱更精简的、更好的回复。

方法1:离线策略(无效果)

- 丰富训练数据多样性:不同响应长度、来源、质量等

- 使用对抗样本暴露弱点

- 改进模型架构。

- 无效果:

无法避免真实动态RL训练里的长度偏见。

方法2:在线监控&重新校准(有效)

- 训练过程中,

实时监控长度偏见。- 长度增加、GenRM得分增加,但指标下降。

- 如果发现,则

停止训练,重新校准GenRM以后再训练。

方法3:补充算法手段

Reward修正、价值裁剪、归一化钝化奖励信号,降低长度bias带来的训练影响。

背景

- 单一策略同时学习推理、通用任务,有挑战。

方法

- 课程设计:

从rule任务开始,逐步混入通用任务。- 先学明确对错的、再学灵活通用的。

- 优点:防止灾难性遗忘,

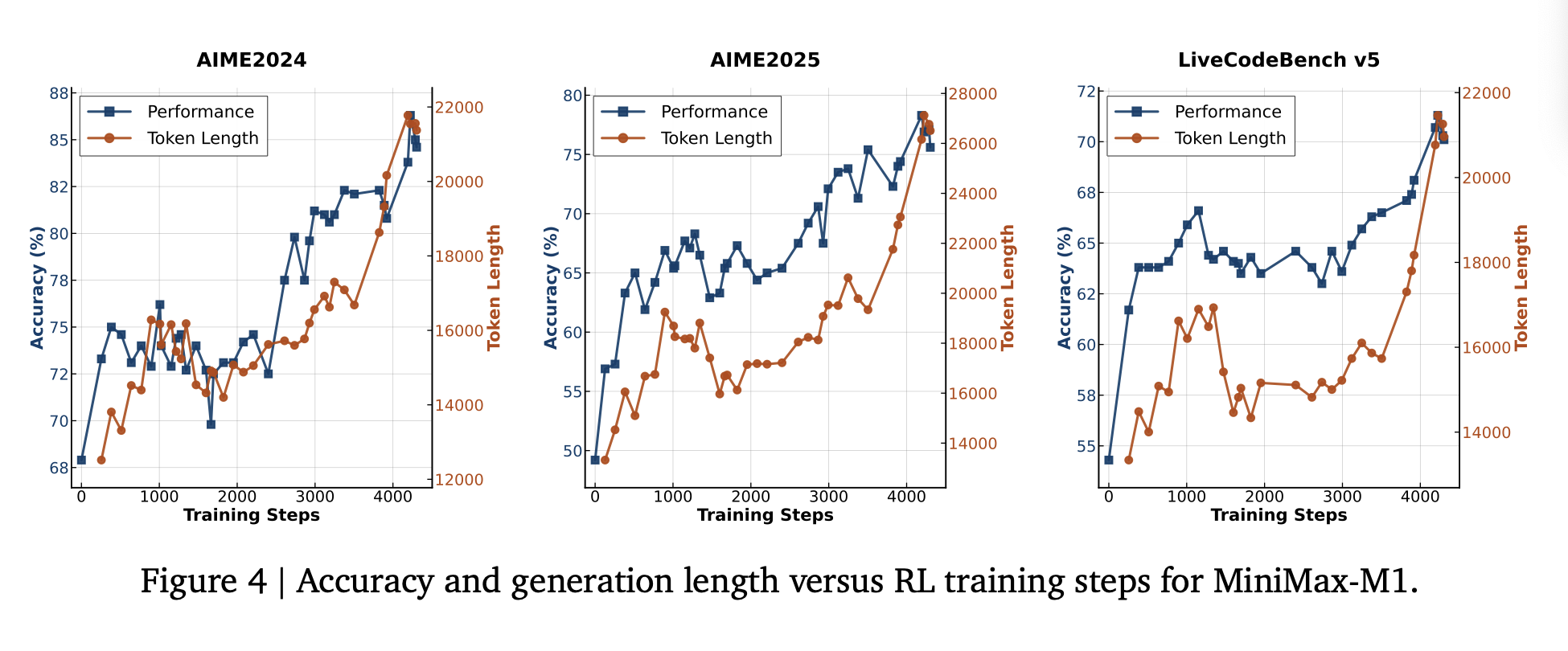

长思考RL Scaling

背景

- 第一步训练:

40k输出长度,MiniMax-M1-40k - Scaling:

80k,目标训练MiniMax-M1-80k

数据

- 过滤:使用M1-40k

过滤易回答样本,保留困难样本。 降采样合成推理数据,因为其会破坏长上下文的RL训练稳定性。

长度扩展策略

- 逐步扩展长度:40k -> 48k -> 56k -> 64k -> 72k -> 80k。

- 优点:保证训练稳定

- 判断依据:

困惑度是否收敛、99%输出长度是否接近上下文窗口限制等

解决训练不稳定问题

- 问题:在

每个长度窗口的训练后期,容易崩溃现象。 - 表现:

生成序列的后半部分,变成语无伦次或乱码文本,通常伴随困惑度增加。 - 根本原因

负样本长度增长速度远高于正样本,大量超长负样本占据主导巨大负梯度累积在序列后半部分。

- 解决方法

- 熔断机制:检测到重复生成无意义内容,

提前终止生成 - 平衡计分:采用

seq-loss和token-loss的归一化组合,避免超多负样本token影响 - 控制更新幅度:降低梯度裁剪阈值和

- 熔断机制:检测到重复生成无意义内容,

算法实验

实验配置

✍️实验设置

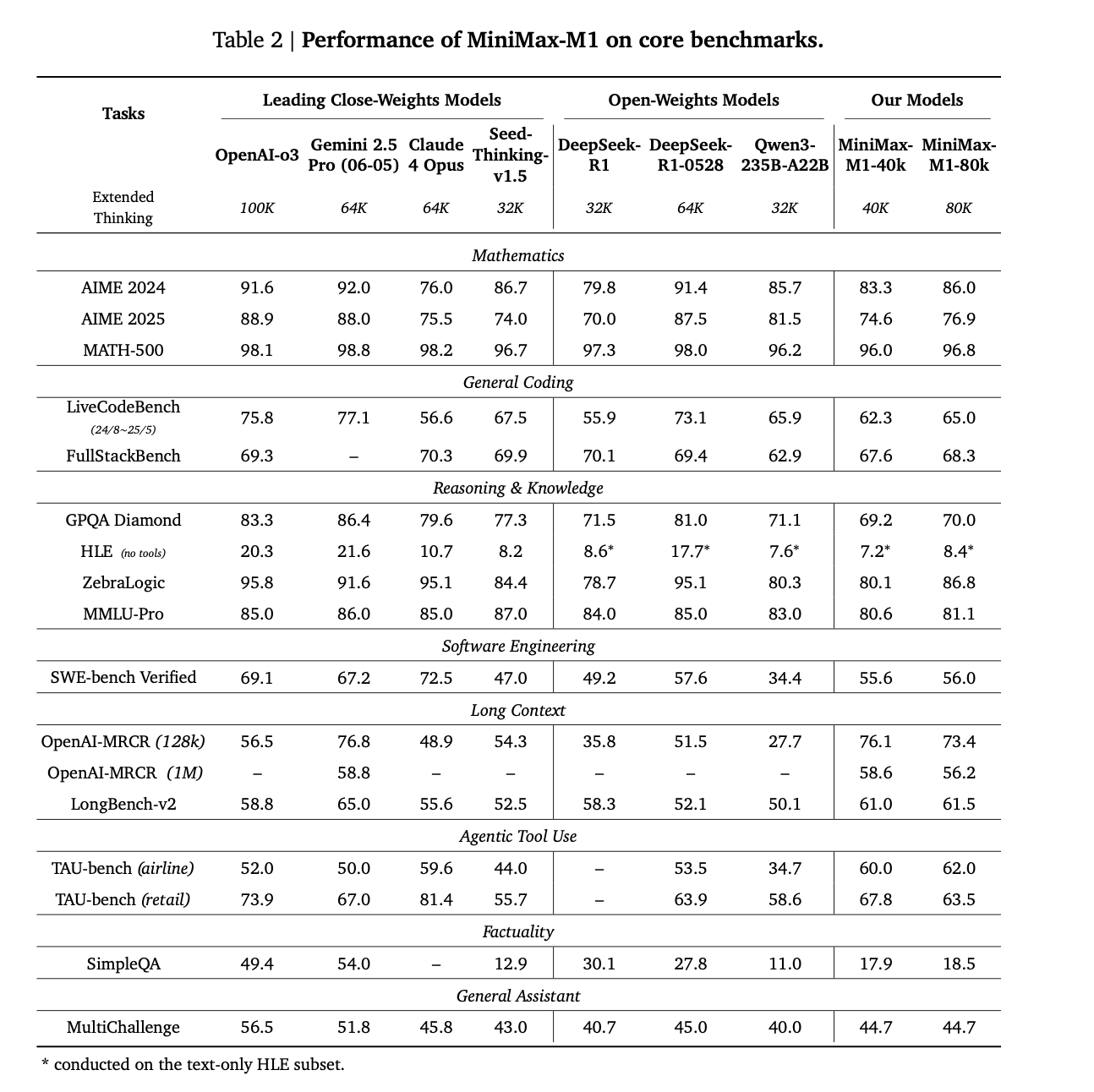

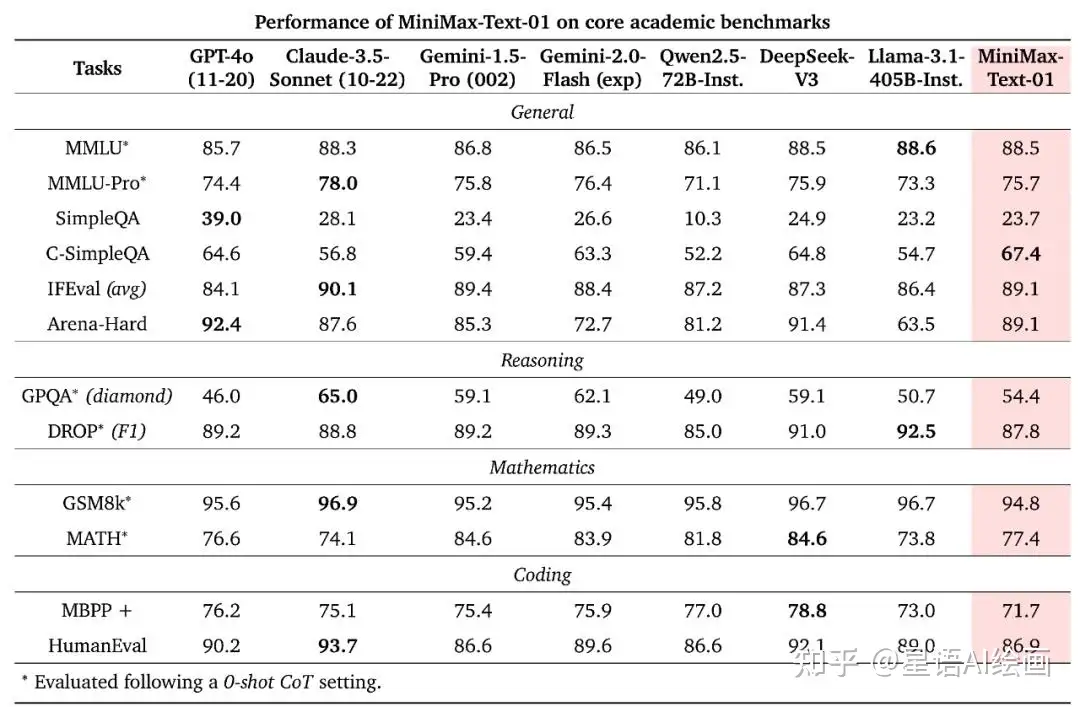

Core Benchmark

- 数学

- Math500、

AIME24/AIME25(采样32次,算平均)

- Math500、

- 代码

LiveCodeBench、FullStackBench- 指标:16次采样

- 推理知识

GPQA-Diamond(32次采样)、MMLU-Pro、HLE Bench(没使用外部工具)、ZebraLogic

- 软件工程

SWE-bench Verified

- 长上下文

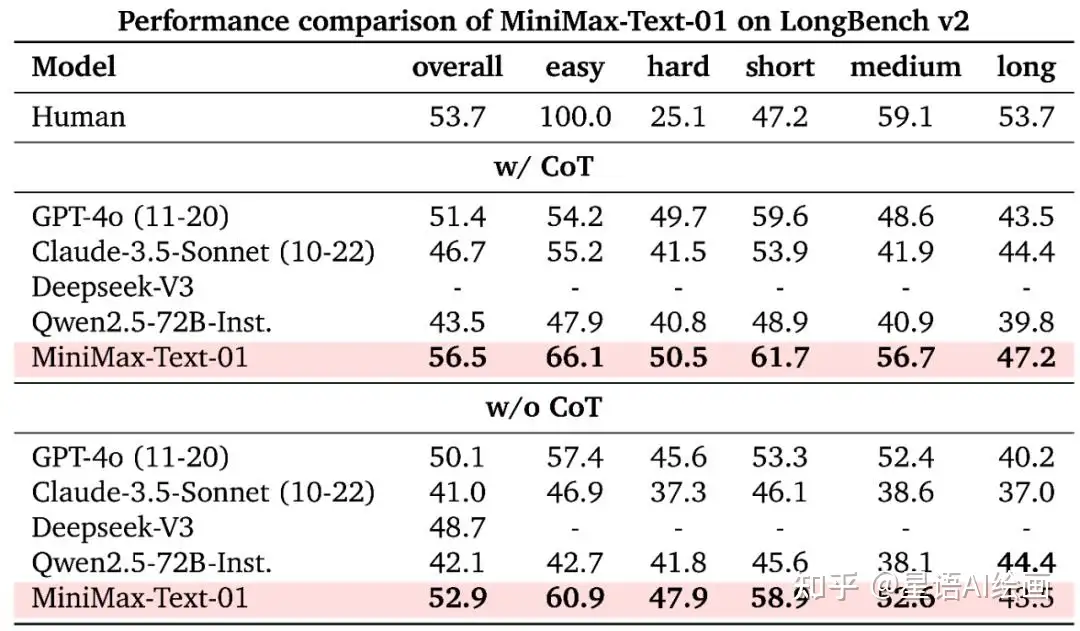

OpenAI-MRCR、LongBench-v2

- Agentic Tool Use

TAU-Bench(最多40步,GPT4.1作为user model)

- 事实性

- SimpleQA

- 通用助手

MultiChallenge(多轮对话,GPT-4o 打分)

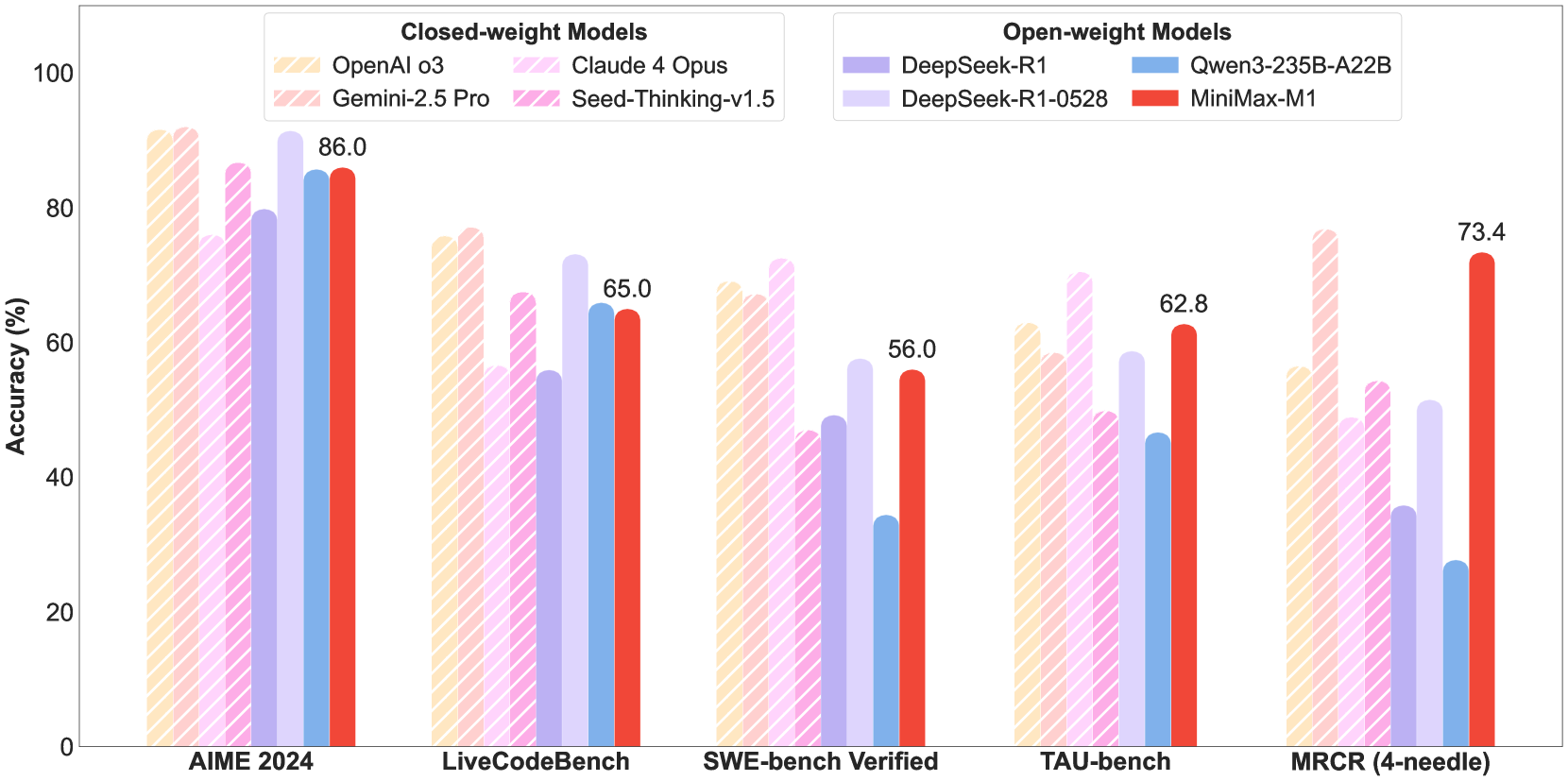

关键结果

🍑关键结果

结果

- 基于MiniMax-Text-01进行RL训练,得到MiniMax-M1

- MiniMax-M1-40k 和 MiniMax-M1-80k,80k生成长度优于40k。

- 在SE/ToolUse/长上下文:超过DeepSeek-R1和Qwen3-235B

- 效率高(线性注意力):

更方便大规模RL训练- Inference:和DeepSeek-R1相比,生成64k 节省50% FLOPS,生成100k 节省只需25% FLOPS。

- 1M超长上下文:

有能力处理复杂真实问题。

指标

- 通用任务:稳居第一梯队

- 数学&编程

- 知识&对话

- 王牌领域:三大榜单统治力效果

- SWE-Bench

- 长上下文:

- 工具使用:TAU-Bench

模型性能和回复长度呈正相关

未来方向

⛳未来方向

- Agent:主导和世界交互、执行复杂任务

- Agent核心要求:长记忆海量信息处理能力、深度推理能力

(2501) MiniMax-01: Scaling Foundation Models with Lightning Attention

MiniMax-01 Paper, 如何评价2025年1月15日发布的 MiniMax-01模型,论文翻译MiniMax-01

解决

长度限制问题,预训练,大规模Scale应用线性注意力,实现超长上下文1M Tokens。Hybrid Lightning Attention,MoE 模型,激活46B,总456B- 同时扩展至多模态,构建MiniMax-Vl-01。

比较详尽的一篇预训练文章

- 网络架构:架构设计、Lightning Attention、尺寸确定

- 预训练:预训练数据构建、数据有效性实验、预训练策略。

- PostTrain:Prompt构建、RewardModel、SFT、DPO、GRPO、安全对齐、长上下文等。

问题背景

❓问题背景

- 当前模型大都在

32k-256k,但对专业书籍、代码项目等真实场景还远远不够。 长度扩展受限于Transformer计算复杂度。学术界处理方法:- Sparse Attention, Linear Attention, 长卷积, State Space模型(Mamba系列)、linear RNN等。

Linear Attention没有在工业界真正大规模scale过。

- MiniMax-01目标:

效果好+超长上下文。

网络架构

整体参数

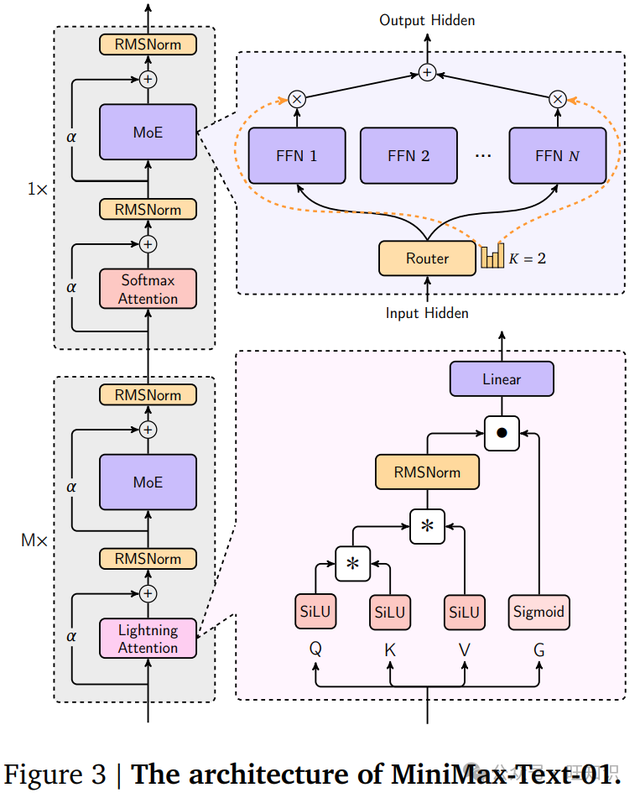

整体架构

- Moe 架构:

456B参数、激活45B、32个专家。

基本单元

- 通道混合器(Channel Mixer,

注意力)- 不同token之间混合信息。

Hybrid Lightning Attention,共2种类型attenion:lightning 注意力:长文本、高效。softmax 注意力:性能强、计算慢。GQA

- 7:1模式:每个7个线性注意力层,就插入1个softmax注意力层。

- 折中方案:保留长序列效率和softmax模型关键性能

- 特征混合器(Feature Mixer,

MLP)- MoE,每个token独立计算。

整体参数

配置参数:MiniMax-Text-01

{

"architectures": [

"MiniMaxText01ForCausalLM"

],

"attention_dropout": 0.0,

"attn_type_list": [

0,...,1, ..., 0 ....

],

"auto_map": {

"AutoConfig": "configuration_minimax_text_01.MiniMaxText01Config",

"AutoModelForCausalLM": "modeling_minimax_text_01.MiniMaxText01ForCausalLM"

},

"bos_token_id": null,

"eos_token_id": null,

"head_dim": 128,

"hidden_act": "silu",

"hidden_size": 6144,

"initializer_range": 0.02,

"intermediate_size": 9216,

"layernorm_full_attention_alpha": 3.5565588200778455,

"layernorm_full_attention_beta": 1.0,

"layernorm_linear_attention_alpha": 3.5565588200778455,

"layernorm_linear_attention_beta": 1.0,

"layernorm_mlp_alpha": 3.5565588200778455,

"layernorm_mlp_beta": 1.0,

"max_position_embeddings": 10240000,

"model_type": "minimax_text_01",

"num_attention_heads": 64,

"num_experts_per_tok": 2,

"num_hidden_layers": 80,

"num_key_value_heads": 8,

"num_local_experts": 32,

"output_router_logits": false,

"postnorm": true,

"rms_norm_eps": 1e-05,

"rope_theta": 10000000,

"rotary_dim": 64,

"router_aux_loss_coef": 0.001,

"router_jitter_noise": 0.0,

"shared_intermediate_size": 0,

"shared_moe_mode": "sigmoid",

"sliding_window": null,

"tie_word_embeddings": false,

"transformers_version": "4.45.2",

"use_cache": true,

"vocab_size": 200064

}MoE

MoE

输入token:

,输出隐向量: Gate网络权重:

,专家: 对

前k个专家的输出进行加权求和

解决路由坍塌/专家平衡问题:辅助loss

问题:大部分token都发送给少数机构专家,出现

赢者通吃现象方法:辅助loss

: 专家i的实际负载,分配的token数量占总token数量的比例: 专家i的平均路由得分。负载和得分的乘积加权求平均,该值越小,说明越均衡。比如极度不均衡(负载比例1和0,路由概率0.99和0.01),loss=0.495非常均衡(负载比例0.5和0.5,路由概率0.5和0.5),loss=0.25

解决负载不均衡问题:Global Router

- 分布式,数据在不同GPU组是随机的,导致

某些组的某些专家恰好收到远超其容量的token。 - 使用

全局路由器,在把token发给够足专家之前,所有GPU组先通过allgather,全局路由掌握全局信息后,进行调度,避免有些组累死、闲死的情况。

Lightning Attention

问题背景

传统SoftmaxAttention 时间复杂度为

,太慢 Linear Attention 时间复杂度为

, 线性依赖于n- 但

cusum操作严格顺序执行太慢,无法真正并行计算,阻碍GPU大规模并行计算。

- Minimax-01 递归写法

- 但

Lightning Attention 核心思想

利用分块技术来计算注意力,

- 把

无法并行的大问题,分解成大量可并行的小问题+少量不可并行的衔接。

- 把

把序列分成2块

- 第一块包含

m个token,第二块包含 剩下的token

- 第一块包含

每块分为

块内计算(传统softmax 并行计算)、块间计算(线性注意力高效计算)。- 大部分并行、小部分串行。

第一块计算

分解成2部分,

块内计算 + 块间计算块内部分

- 块内部的自我注意力。

- 采用

softmax注意力、左乘形式,因为m比较小。完全并行计算。

块间部分

- 代表了第一块中每个token对它之前所有历史信息的注意力

:从第0个块传递来的状态矩阵 - 采用

线性注意力、右乘形式,非常高效。

状态更新

- 第一块计算完成后,更新状态。把第一块的信息累计到状态矩阵中。

第二块更新

分解成2部分,块间计算 + 块内计算

计算同第一块。

Hybrid Lighting Attention

Hybrid Lighting Attention

- 结合

lightning和softmax attention 7:1模式,每7个lighting就插入1个softmax

Softmax vs 线性注意力

- Softmax 注意力

- 通读书籍,

处理第t个词时,会把之前的所有词都过一遍。 - 优点:记忆力好,检索能力强;缺点:

计算量大。 容量:草稿纸大小, 128。

- 通读书籍,

- 线性注意力

- 直觉上:无法有效检索。

- 但

通过容量来记录压缩历史信息:循环更新的状态矩阵大小,, 容量:草稿纸大小, 128*128/64=256

- 但在容量上,线性注意力更大

- 提升了效率、支持更长上下文。

- 在模型效果上也带来提升。

- 在信息检索、外推任务上,混合模型反而还超过了纯softmax模型。

- 能充分发挥Post-Layer Norm的优点

使用Hybrid后,实验Post-LN比Pre-LN 效果更好,从43.9 -> 50.2。- 性能大于风险。

模型尺寸形状确定过程

第一步:小模型做实验确定关键参数配比

- 使用

大量小实验,来寻找最佳实践。- 混合比例:线性和softmax 注意力配比

- 深宽比:瘦高个(层数多、每层窄) 还是 矮胖子 (层数少、每层宽)?

- 内部配置:线性注意力的记忆该设多大?RoPE用在多少维度上?

- 结论:对混合架构来说,

模型深度更好。

第二步:用定制化的scaling law 预测规模

像Chinchilla这样著名的scaling law

不适用当前架构,需定制化scaling law模型规格

Loss

给定

激活参数、Token数量、专家数量E条件下由

激活参数数量和训练token数T决定,其余是需拟合的参数

最终确定:

456B总参数、46B激活参数

预训练

预训练数据

数据来源

- 整体来自于学术文献、书籍、互联网、编程代码等。

数据质量增强

- 基于

规则清洗+去重 - 基于上一代MoE模型作为

Reward模型,在多个维度上进行打分连贯性、简洁性、教育价值、有用性、知识丰富度、类别相关性等。- 最终确定:

知识深度、实用性、类别分布作为主要指标。 - 类别分布(新闻小说代码等):

确保每种类型数据都有,避免模型偏科。

数据格式优化

- 网站和数据数据:提取后就作为高质量数据,无需格式化。

- 对话和问答数据:

过度格式化会降低数据多样性和质量。- 设计了一套嵌套问答格式,平衡了自然理解和结构一致性。

数据混合

- 利用3个质量指标,开发了复杂方法,来调整数据分布。

完全删掉低分内容,会影响下游任务性能。- 尽管使用知识深度、有用性更高的数据,在指标评估上会更好。

- 平衡采样策略

- 从基础语料库

均匀分布开始,逐步调整采样权重,慢慢偏向高质量内容 - 同时

保持不同类别

- 从基础语料库

数据有效性实验

实验目的

- 使用

特征不同但数量大小相同的数据,训多个小MoE模型,来评估单个数据的影响。 - 不是靠人盲猜哪些数据有用。

衡量指标

多选Benchmark,但去掉选项索引,评估模型生成正确答案的对数归一化准确率:样本i、选项c的字节归一化概率

实验设置

40B token数据,训练激活1B、总参数8B的模型。- 混合数据:

20B web文档数据+20B 假设数据。

重复数据的影响

低质量数据:训练2轮以后,性能开始下降。高质量数据:最多训练4轮。

训练策略

参数

- Xavier 均匀分布初始化策略

- Adam 优化器,

- 动态逐步调大batch size

初始16M->32M(69B)->64M (790B)->120M(4.7T tokens)- 根据数学方程,

预测当前模型loss,来计算batch size。 - 前期:

模型不稳定,使用小batch size更容易收敛。 - 后期:

模型稳定, 使用大batch size来加速训练。

- 学习率

- warm up:500次迭代,达峰值

,保持稳定直到7.2T tokens。 - 发现gradient norm过高异常,可能是学习率过大。

- 剩余3.2T tokens:学习率调整为

- 快速衰减阶段 1T Tokens:学习率指数及衰减至

- warm up:500次迭代,达峰值

- MoE 辅助loss系数:0.01

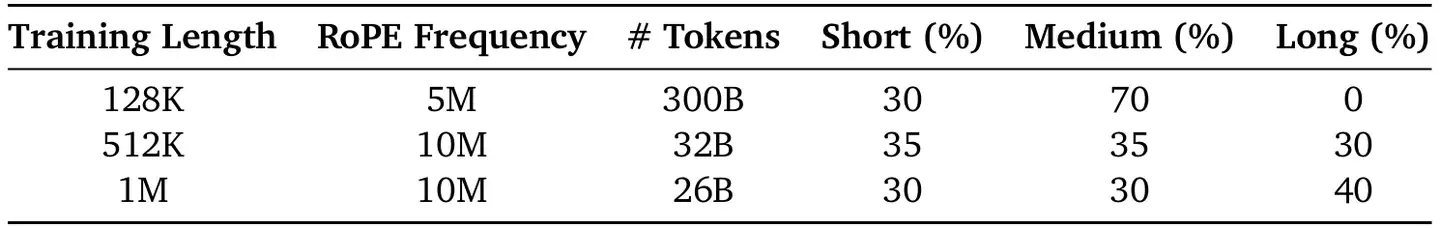

上下文扩展:3阶段训练策略

- 阶段1:

128k,RoPEFreq 5M,300Btoken - 阶段2:

512k,RoPEFreq 10M,32Btoken - 阶段3:

1M,RoPEFreq 10M,26Btoken - Trick

- 每个阶段的

后20%周期里,混入10%的高质量长上下文问答数据,长度分布和预训练相似。 - 减轻分布变化导致的不稳定性:过渡阶段使用源特定权重的线性插值。

- 每个阶段的

VL 模型

- 集成ViT,训练MiniMax-VL-01:在5120亿视觉token上进行训练,使用4阶段训练过程。

Post Train

Prompt 构建

- 从多个源,收集了

数百万、多样化、高质量的prompt。- 领域:长上下文、编程、数学、逻辑推理、创意写作、函数调用、通用知识和安全等。

- 打标系统:按

任务类型、知识领域、任务难度做分类。 - 重复过滤:

消除重复prmpt,保持最佳难度分布

Reward Model

核心思想

- 从4个维度,来评估回复。

正确性/Correctness

- 针对

可被验证的任务- 数学推理:使用早期

MiniMax-Text-01,基于答案一致性,生成2元奖励。- 一致、不一致。

- 代码编程:沙盒环境,

测试用例的成功率。

- 数学推理:使用早期

真实性/Truthfulness

- 评估

事实准确性,一个pipeline- 系统抽样,

人工众包验证、先进大模型验证

- 系统抽样,

有用性/Helpfulness

- 评估

是否对用户有帮助,比如遵循理解指令。自动化规则检查、人工主观评估

无害性/Harmlessness

- 评估是否

安全、合乎道德和法律。- 早期

MiniMax-Text-01做安全性检查。

- 早期

SFT

数据构建

多阶段过程,利用了通过迭代 SFT+RL循环训出的领域特定专家模型。- 使用

专家+拒绝采样,生成高质量回复。- 每个prompt,在

不同温度下,生成多个回答 - 基于

奖励系统,选出最优的回答。

- 每个prompt,在

- 整合

n-gram相似度+语义相似度过滤器,确保训练数据多样性和高质量。

RL-offline(DPO)

- 使用 DPO,因为

简单、在长上下文下好构造数据。 - 数据构造

Prompt:使用SFT-Trained-Prompt。SFT-Untrained-Prompt 性能差异不大。Responses:不同温度下的回复- 基于

奖励系统,选出最佳、最差回复,构建出偏好对。

RL-online(GRPO)

背景

- 在线RL比离线RL好:

样本效率高、领域泛化性好。

数据集

SFT-Untrained-Prompt- 如果使用SFT-Trained-Prompt,会导致

模型饱和,表现为困惑度降低。

- 如果使用SFT-Trained-Prompt,会导致

数学推理任务,使用中等难度的题

GRPO变体

IS权重 CLIP 优化

- 传统GRPO问题:在IS大+负优势值时,容易导致梯度不稳定。

- 改进:额外clip,直接丢弃这种case,减轻了噪声传播

KL 散度优化:

- 进一步稳定梯度,

重新构建KL项

- 进一步稳定梯度,

平衡优势估计

- 确保

正负样本的奖励贡献是公平的,保证训练稳定。 - 在分布不平衡时,特别有效。

- 确保

安全对齐

数据构建

- 保证

多样性、准确性。 - 特定安全类别Prompt

- 利用已有安全分类标准,为每个类别定制prompt

- 真实场景用户数据

- 收集

- Prompt 扩充

- 基于早期MiniMax-Text-01,基于red team attack prompt,

扩充prompt。 - 增强鲁棒性

- 基于早期MiniMax-Text-01,基于red team attack prompt,

Hamless Reward Model 的回复

- 基于

安全规则,开发了一个无害的Reward Model。 - 防止过度拒绝:把

Helpfulness加入安全规则中。

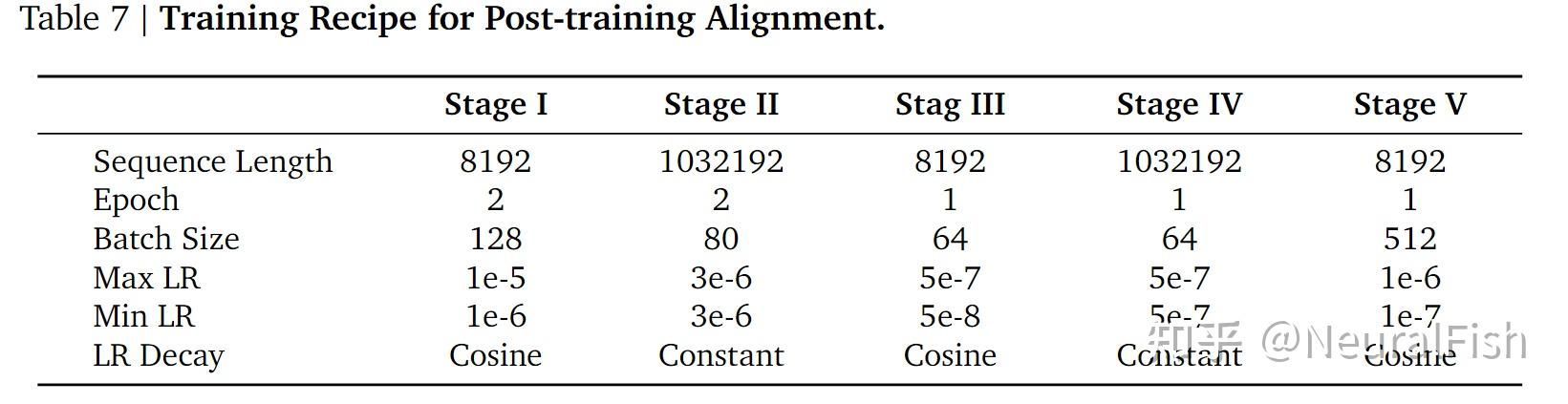

长上下文训练

核心思想

五阶段训练方法,长短交替,SFT+DPO+GRPO。- 增强长序列能力、保持短序列效果。

多阶段训练方法

- Stage1 (SFT, 8k) 短上下文训练

- 8k,过滤超过8k的数据

- State2 (SFT, 1M) 长上下文训练

- 1M,50%都是长Prompt,适应长上下文

- State3 (DPO, 8k)

- 8k,校准,保证短序列效果、保证长序列效果。

- State4 (DPO, 1M)

- 1M,精通长文本

- Stage5(GRPO, 8k)

- 8k,提升数学推理等能力。

多模态模型

核心思想

- 把Image Encoder + Image Adapter 适配到MiniMax-Text-01,开发出MiniMax-VL-01。

数据集

图文标题数据

- 互联网收集过滤,庞大的

图文标题数据。 - ViT 在

6.94亿 图文对上进行训练,为其中的1.8亿构建精选标题,

图像描述数据

1亿,来自Common Crawl等。- 每张图有

细粒度描述,模型生成+人工精炼,描述大概300token。

指令数据

合成大量涉及视觉的QA数据,构建了全面多样化的指令数据集。- 领域:OCR、物体定位、几何问题等等。

整体架构

整体架构

- 视觉编码:

3B 的 ViT-L/14- 动态分辨率,

336*336 -> 2016*2016 - 直接利用原始特征,从头开始训练

- 动态分辨率,

- 图形适配器:

随机初始化的双层MLP - LLM:MiniMax-Text-01

训练策略

阶段1:模态对齐

- 目标:

给定图像,生成标题,实现视觉和文本token对齐。 - 训练:

ViT+Adapter的权重。 - 分辨率:336×336

阶段2:增强视觉理解

- 目标:

模型输出和人类指令对齐 - 训练:所有模型参数。

- 数据:从

指令数据采样4200亿多模态token,配比MiniMax-Text-01后训练数据(20:1)

阶段3:增强用户体验

- 目标:

真实场景效果 - 数据:日常图片数据、模拟真实用户输入、精心标注。

阶段4:增强偏好

- 目标:DPO

- 数据:4万个图文对数据

- Prompt:从指令和真实用户数据中

精心筛选prompt - Response:

多种策略(温度/图形弱化/引入幻觉等)生成Responses - 奖励:

MiniMax-Text-01 作为评估器,多维度评估 - 偏好对:选择

得分最高和最低的作为正负样本。

- Prompt:从指令和真实用户数据中

框架优化

计算

- 现有框架对softmax attention进行优化,但MiniMax-01是

lightning+softmax+moe架构。 - 框架优化

- 减少跨GPU开销:

Expert 并行+Expert Tensor 并行,来实现MoE中的all-to-all通信。 - 上下文:使用

变长环形注意力减少冗余计算,实现Linear Attention 序列并行(LASP) - 量身定制的CUDA核心,H20上超过75%的浮点运算利用率。

- 减少跨GPU开销:

关键结果

🍑关键结果

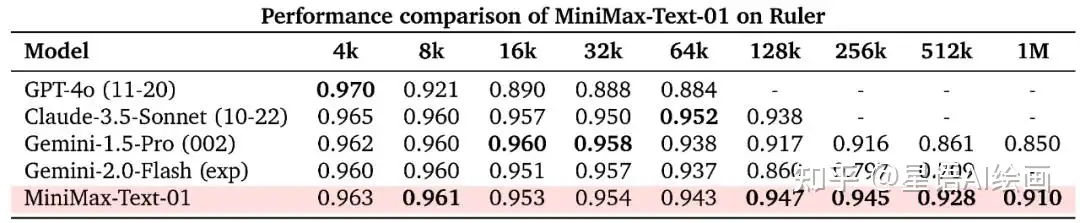

- 打破常规:效果好而且不依赖传统softmax注意力,大规模应用线性注意力。

- 极致的上下文能力:400万token,效果匹配顶尖闭源模型

- 一套探索各种模型、数据集、评估和算法的适用方法论。

能高效处理1M-4M tokens,超长上下文,效果优于Gemini1.5-Pro。

大海捞针,检索任务,效果也很好:

学术任务上,也很出色。

长上下文学习能力,也很好。

未来方向

⛳未来方向

长上下文评估体系:贴近现实真实场景、难度更高的长上下文评测极致的架构:目前是线性和softmax 7:1,期望终极目标是100%高效上下文,无限长上下文补齐代码能力:预训练数据中代码比例和质量有限,

:::``