(2512) DeepSeek-V3.2

🌺 论文摘要

问题背景

❓问题背景

- 开源和闭源

差距越来越大,闭源模型性能提升很快,处理复杂任务能力很强。- 开源:MiniMax, Kimi, Qwen, GLM

- 闭源:Claude 4.5, Gemini3 Pro, GPT-5

- 三个原因

- 架构缺陷:Softmax注意力 平方复杂度,

长文本太贵太慢。 后训练资源投入不足:限制高难任务,大部分都在预训练上,后训练做的少。- Agent效果不足:

泛化指令和指令遵循效果不好。

- 架构缺陷:Softmax注意力 平方复杂度,

模型架构

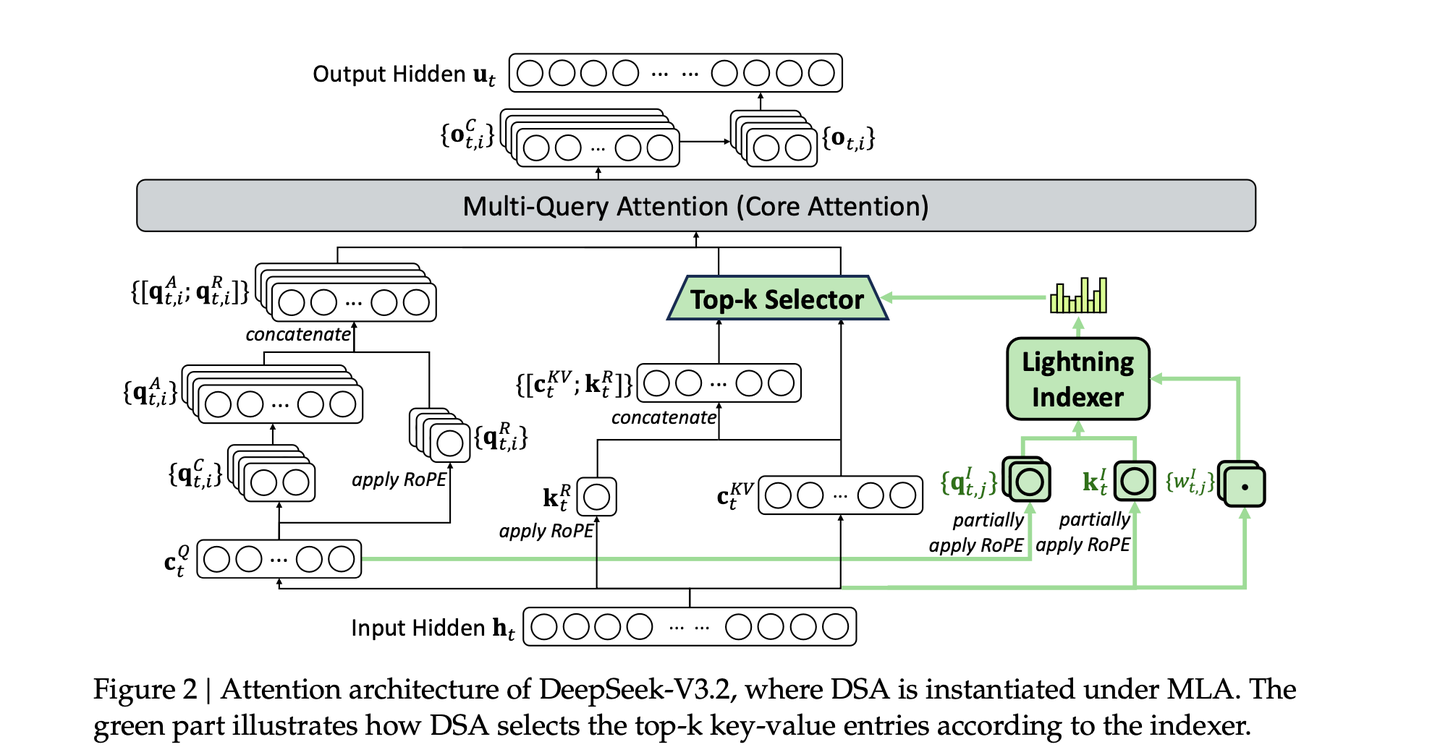

DeepSeek Sparse Attention

整体同DeepSeek-V3.2-Exp一致,通过DeepSeek-V3.1-Terminus 继续训练,区别仅是通过CPT来引入DSA。

Lightning Indexer

符号定义

: Query token;: 前面的某token;: 二者的索引分数,: 索引头数量:来自query-token ; :来自前面-token ,

使用

超轻向量计算 索引分值,决定 哪些token被选中。使用

FP8(吞吐量高)+ReLU(比softmax快)

细粒度Token Topk选择器

- 对query token

, 仅 稀疏选择top-k的token(Key-Value对),去 计算注意力。

DSA 和 MLA 结合

继续预训练

整体

- Checkpoint: Base-DeepSeek-V3.1-Terminus;数据:上下文长度

128k。 - 分为

Dense预热和Sparse训练2阶段。

Dense 预热阶段

目标:初始化Lighting Indexer,学会预测哪些token是重要的。

方法:

冻结主模型参数,仅训练Indexer参数。训练目标:

KL Loss作为训练目标,让indexer预测分布接近DenseAttention分布。Teacher:DenseAttention, 目标分布,; Student:SparseAttention

共训

2.1B tokens。lr=1e-3,1000步,每步16个序列,每序列128k token,

Sparse 训练阶段

正式训练稀疏注意力,同时

训练主模型和indexer,每个query token,

不看所有128k token,而是仅看2048个token,执行Top-k选择。共训

943B tokens。lr=7.3e-6,训练1.5w步,每步480序列,每序列128k。

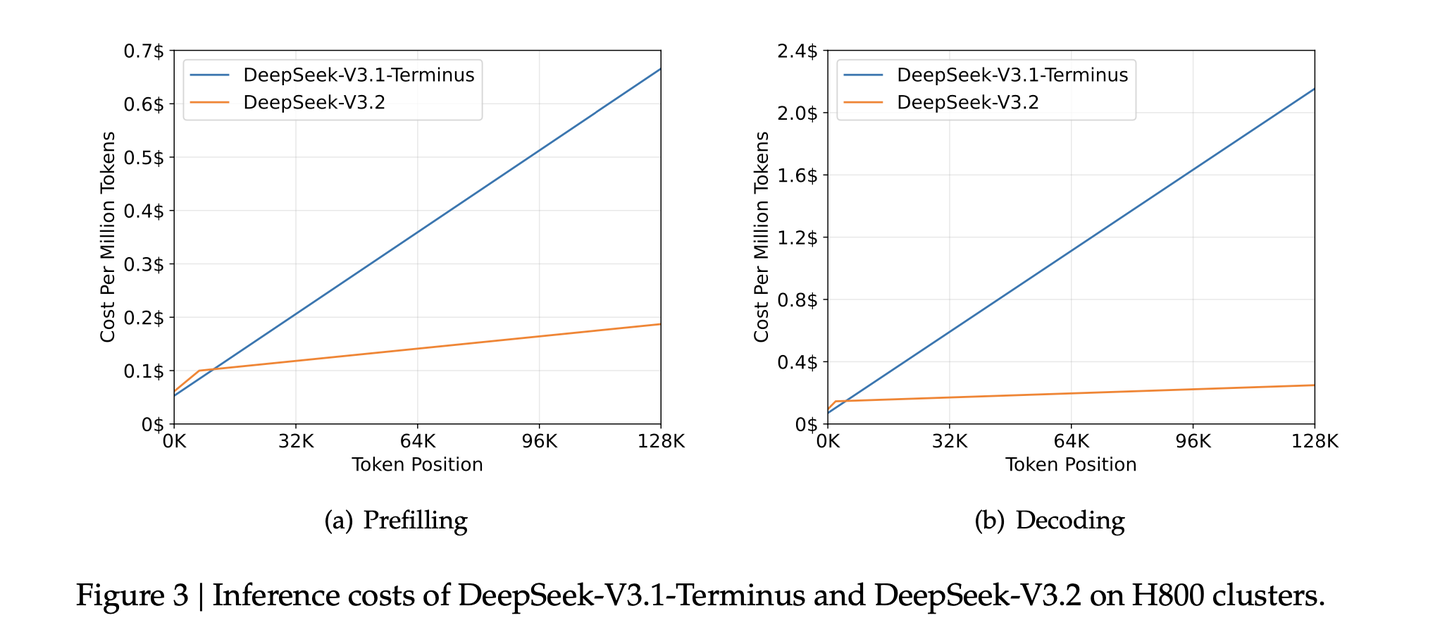

整体效果,在标准Benchmark、人工偏好、长上下文上,DSA和之前模型,效果一致,并未出现明显下降,但推理成本得到极大下降。

Post-Train

专家蒸馏训练

- 从DeepSeek-V3.2-Base,

8大领域单独训练一个专家模型- 写作、问答、数学、编程、逻辑推理、

通用agentic任务、agentic编程、agentic搜索

- 写作、问答、数学、编程、逻辑推理、

- 专家训练:

都经过单独RL训练,各专家支持思考和非思考模式。- 但具体细节,似乎没见过。

- 知识蒸馏:使用专家生成

长推理和直接回复数据。 使用蒸馏数据,去训练Base模型。后续再接下文的Mixed RL训练- 通才单模型仅比多专才效果低一点点。

Mixed-RL训练

- 混合训练:

推理+agent+人类对齐。GRPO算法。推理+Agent:Rule-Based奖励+长度惩罚+语言一致性奖励。其他通用任务:GenRM,每个任务有一个rubrics

- 优点:

平衡不同领域性能,解决灾难性遗忘问题。

Scaling GRPO

📕核心方法

IS权重优化KL3估计

问题:当

- 当前策略概率低,但参考策略概率高,认为生成了不该生成的内容。

- K3估计器的梯度,会

给这些token分配极大、无边界的权重 - 会

导致梯度瞬间爆炸,引入噪声,训练不稳定

无偏KL估计

核心:

重要性采样比例*原始K3估计。乘以

,无论采样如何,梯度 期望值都是准确的,消除了系统误差,梯度变无偏估计。

KL 实践参数设定

不同领域任务,所需的KL不一样。通用对话/文案任务:需较强KL,保持语言流畅风格一致性。数学/逻辑推理:就几乎无需KL。

Mask 异策略负样本

异策略负样本可能有害

- 直观上,模型从自己的错误中学习是有效果的,但

高度异策略的负样本,很可能是有害的。 - 训推不一致:

推理框架高度优化,和训练框架可能不一致,加剧了异策略程度。- Off-Policy:把

1次rollout样本分多个mini-batches,做多次梯度更新 - 更新第2次以后:

采样策略和更新策略不一致。

- Off-Policy:把

- KL散度和IS权重的区别

Mask 异策略负样本

Mask不好的序列,不学它,差序列定义如下:- 结果不好:

, 优势为负 - 偏差大:

, KL差异大,rollout模型和当前模型差异大

- 结果不好:

系数计算公式

序列级KL散度:序列内所有token的KL值做平均,作为序列级KL散度,设定最大阈值Token级系数, 优势为负且KL差异较大时,设为0

目标

保持路由和采样Mask 消除训推不一致

核心:消除训练和推理时的不一致

Keep Routing:消除模型结构动态性带来的不一致。Keep Sampling Mask:消除概率空间截断带来的不一致。

保持MoE路由

- 问题:

采样时:Router选择专家A和B;训练时:Router却选择专家B和C。- 专家A做贡献没被更新,专家C没做事情却被更新,导致

参数更新方向很随机,导致训练崩溃

- 方法:

Routing Replay。- 推理时,

记录每个token选择的专家;训练时,不计算路由,强制使用推理时的专家。 - GSPO 序列级IS权重:无token级IS,

评估整个句子,无需Routing Replay,对底层专家不敏感,

- 推理时,

保持采样Mask

- 问题:

- 推理时,通常使用top-p, top-k来提高回复质量,

低概率token概率为0,相当于词表截断。 - 训练时,计算IS权重,则

和 动作空间/定义域 不一样,导致计算失效。

- 推理时,通常使用top-p, top-k来提高回复质量,

- 方法

保留采样Mask,在训练时应用到,该部分概率为0。保证 和 词表一致。

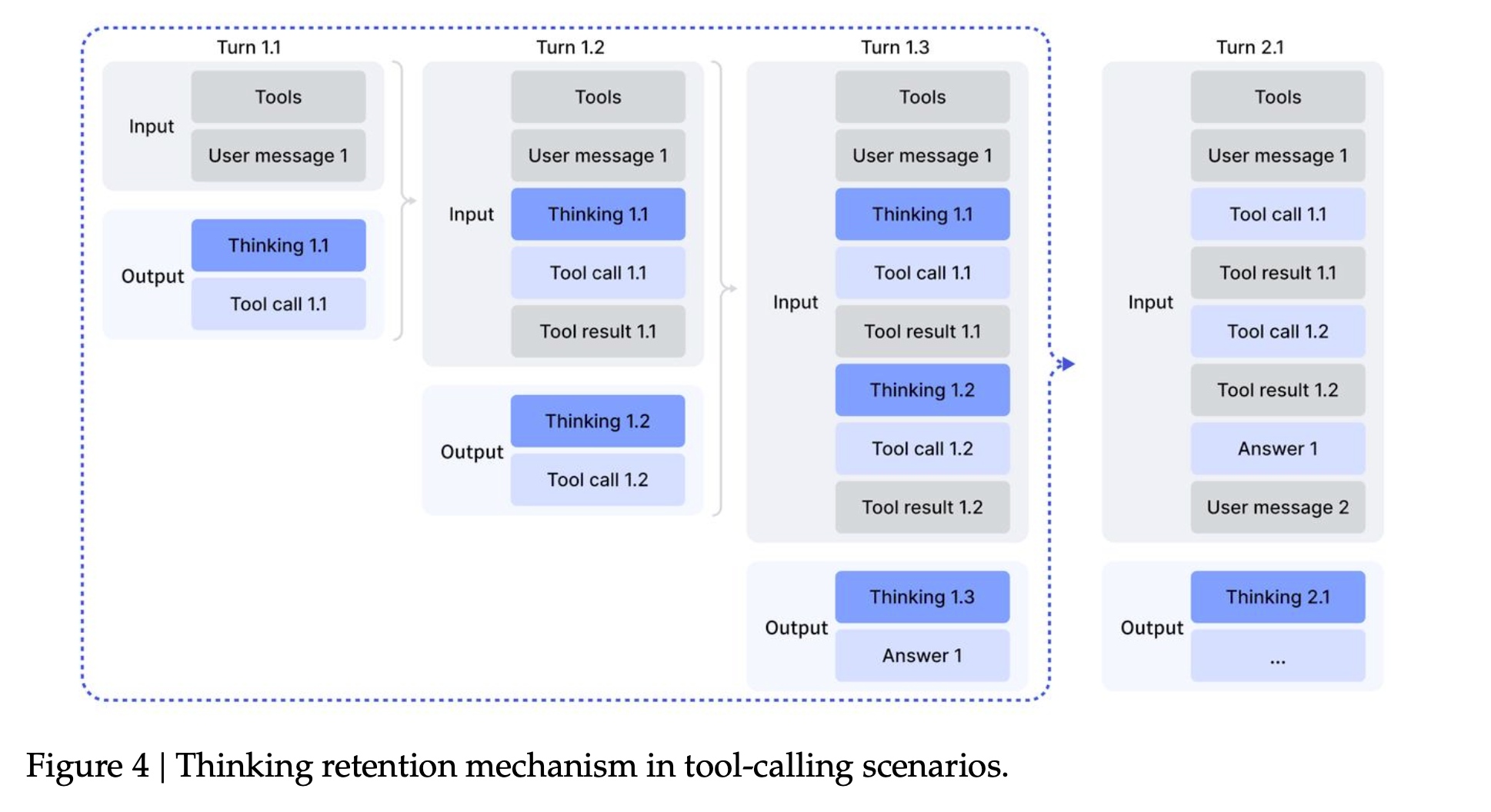

Thinking in Tool-Use

工具调用思考-上下文管理

- 仅在

新的User消息到达时,才丢弃之前的思考内容。 - 若无新的User消息,则在

每一步的工具调用中,保留每步的思考过程,不像R1那样每一步都丢弃和重新思考。 - 具体如下图所示:Thinking - Tool Call - Thinking - Tool Call

- 背景:测试时,某些场景128k 仍然不够

- 方法:测试时,引入

上下文管理,token超过80%时:Summary:总结轨迹并重新启动Rollout过程Discard-75%:丢弃前75%的工具调用历史来腾出空间Discard-all:丢弃所有的工具调用历史来重置上下文

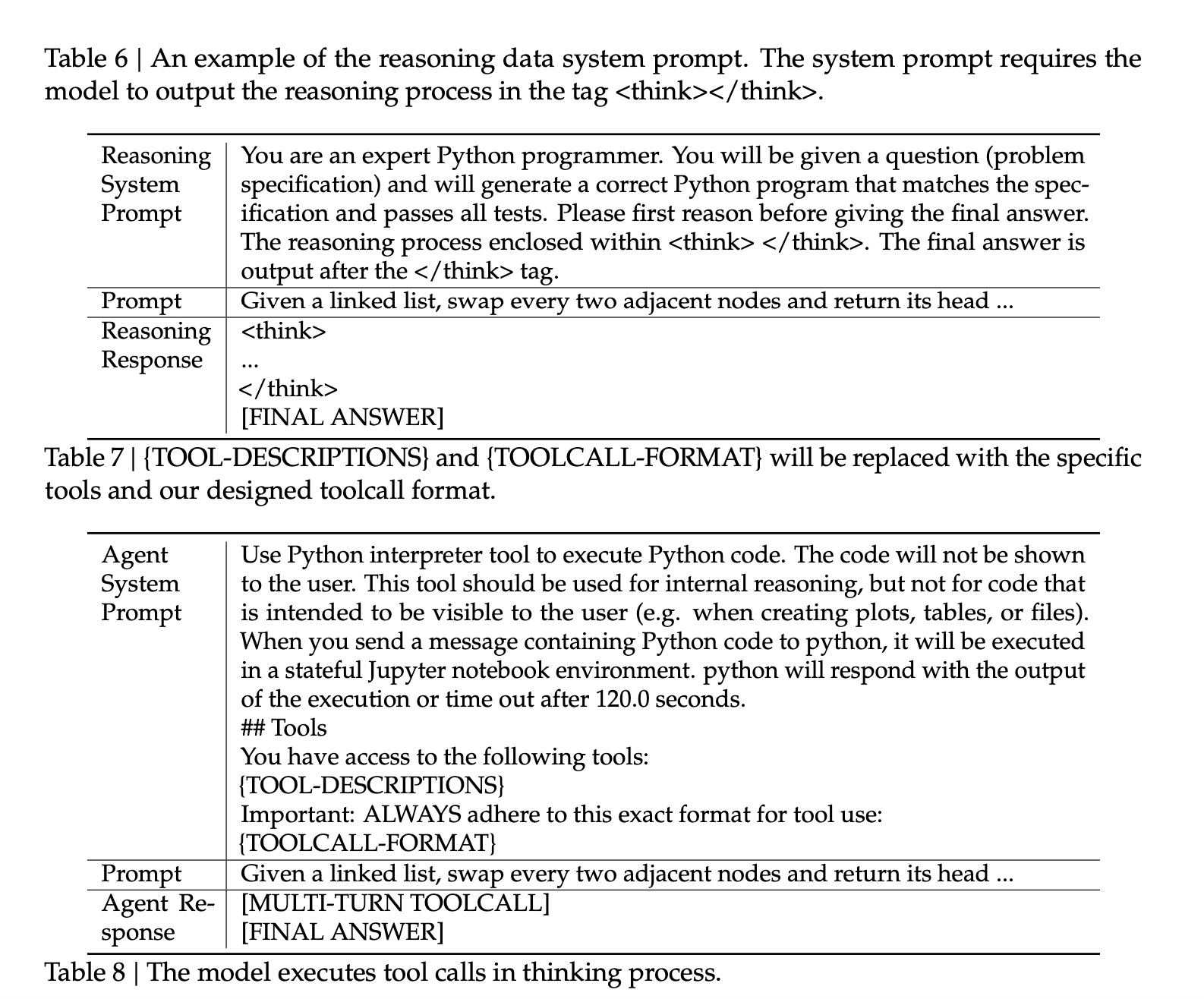

自蒸馏冷启动

背景

- 目标:想要一个既能

深度思考(R1-Style)、又能熟练使用工具(Agentic Style)的模型。 - 现有数据:

推理数据-非Agent,Agent数据-无推理。

方法

- 利用

指令跟随能力,设计Prompt,把推理思考和工具使用合在一起。不同任务需不同的system prompt。

- 虽然

成功率低,但也可提取出成功轨迹作为正样本。 - 滚雪球冷启动:

SFT 微调->收集正样本->SFT 微调....,逐渐提高成功率,后续可做大规模RL

大规模Agentic任务构建

📕核心方法

Search Agent

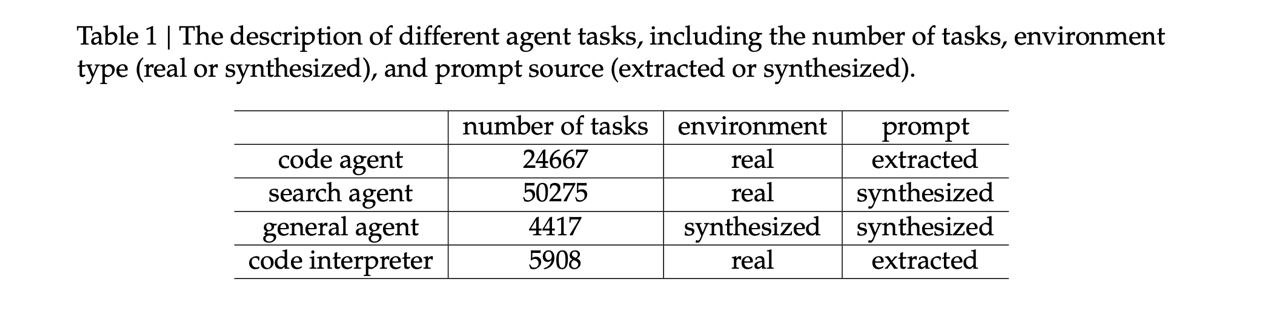

- 50k任务,真实环境,合成任务。

- 基于DeepSeek-V3.2

Mulit-Agent Pipeline合成 多样高质量数据- 从web数据中挖掘出

长尾实体 - 问题构建Agent:使用

搜索工具探索实体,把信息整合成QA对。 - 多个答案生成Agent:配置不同,为QA对

生成候选答案。 - 验证Agent:具有搜索能力+多轮验证,仅保留

GT正确且所有候选答案错误的难样本。

- 从web数据中挖掘出

- GenRM:设计覆盖

多个质量维度的rubrics,来打分。

Code Agent

- 24k任务,真实环境,提取Prompt。

- 从

数百万Github Issue-PR中,构建大规模软件Issue解决的可执行环境。- 数据过滤:启发式规则+LLM,确保每条包括:

合理的Issue描述、Gold Patch、Test Patch。

- 环境构建Agent(DeepSeek-V3.2):负责

包安装、依赖解析和测试执行。- 测试输出:标准JUnit格式

- 环境构建成功标准:Gold Patch应用后,Fail-to-Pass和Pass-to-Fail都为0

- 最终构建:

数万个高质量多语言Issue解决RL交互环境.

- 数据过滤:启发式规则+LLM,确保每条包括:

Code Interpreter Agent

- 5.9k任务,真实环境,提取Prompt。

- 使用

Jupter Notebook作为代码解释器,解决复杂推理任务。 - 数据集构建:数学+逻辑+数据科学,

每个问题需使用代码来解决。

General Agent

4.4k任务,1.8k合成环境,合成prompt。

自动环境构建Agent:合成了1827个任务环境。

难解决却好验证的任务。- 数据检索存储:给定

任务类别+Sandbox(bash+搜索功能),Agent搜索数据并存入数据库。 - 构建工具:Agent

为任务合成工具,工具即函数。 - 初始任务生成:基于数据库合成

简单任务+Solution+Verification,python实现。- 限制:Solution

只能调用工具,不能调用其他函数或直接访问数据库 - 一致性检查:

Solution结果必须通过验证函数校验,不断修改,直到通过为止。

- 限制:Solution

- 难度升级:迭代

增加任务难度,更新解决方案和验证函数,以及扩充工具集。 - 最终得到几千条数据:

环境+工具集合+任务+验证器

- 数据检索存储:给定

数据筛选:筛选出

有难度可执行的优质任务,而非直接使用所有数据。- 使用DeepSeek-V3.2 解决100次,

留下pass@100 > 0的任务。

- 使用DeepSeek-V3.2 解决100次,

算法实验

实验设置

✍️实验设置

基础模型

- DeepSeek-V3.2 Base

训练任务/数据

- CPT:没写,数据长度128k。

- 专家蒸馏:8大领域,各训一个专家模型。

- Mixed-RL 训练:也没写。

Agentic 任务:4大类,8.5w。

评测任务/数据

- 通用:MMLU-Pro, GPQA Diamond.

- 数学:AIME 2025, HMMT 2025, IMO 2025.

- 代码:Codeforces, LiveCodeBench, SWE-bench Verified.

- Agent:BrowseComp,

-Bench, Terminal Bench 2.0.

算法/策略

- Scaling GRPO

超参

- 长度:128k

- RL训练:混合思考和直出2种模式

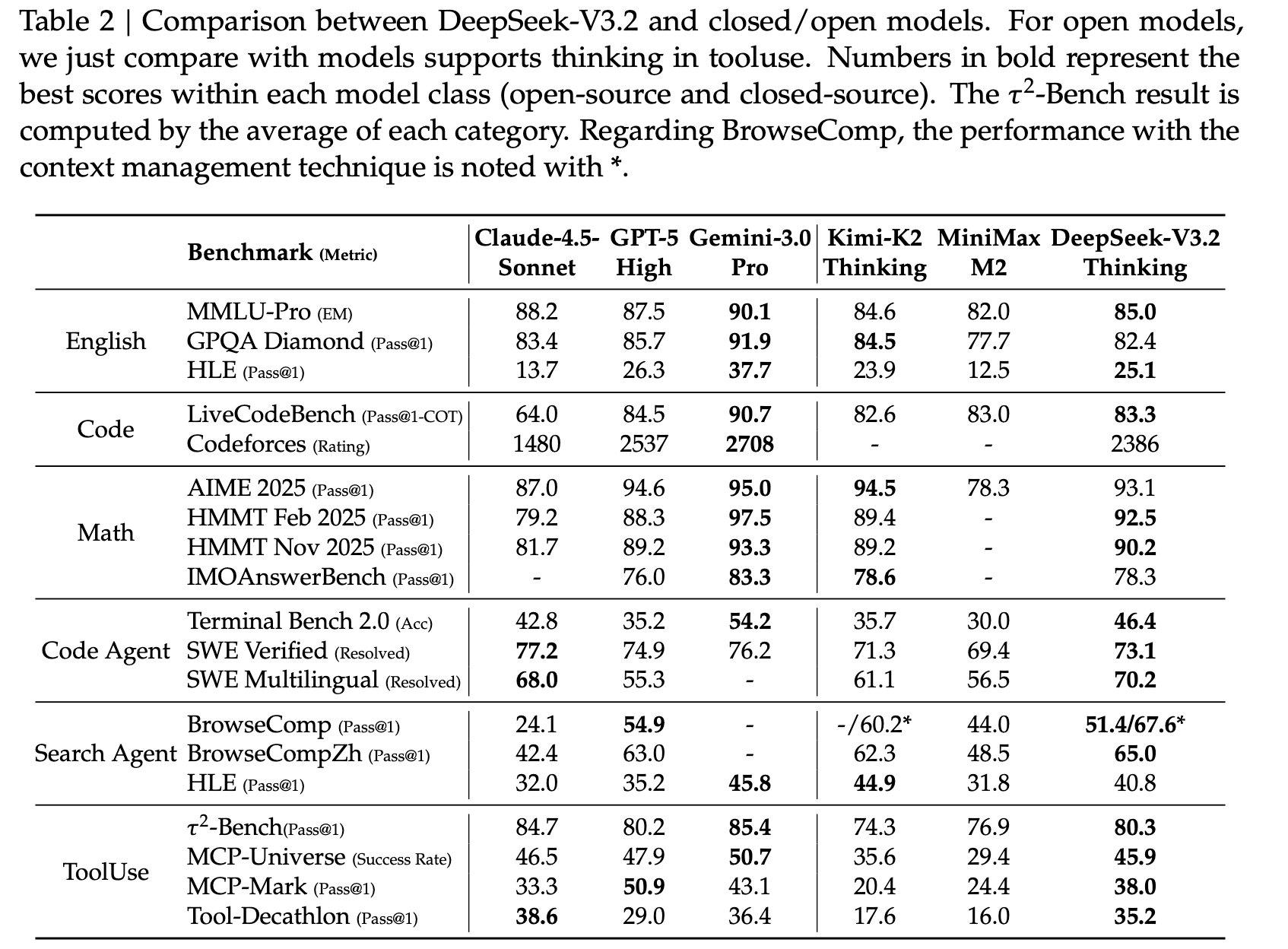

关键结果

🍑关键结果

Post-Training 评估

- 推理任务

- DeepSeek-V3.2 在推理任务上的性能与 GPT-5-high 相近,略低于 Gemini3-Pro。

- 与K2-Thinking相比,DeepSeek-V3.2得分相当,但

输出token数量少得多。 - 原因:RL预算增加,已达预训练的10%;性能受长度约束RM限制,去掉后还能提升。

- 代码任务:

- SWE-Bench和Terminal2.0:超过开源模型,后者基于ClaudeCode框架实现。

- 搜索任务

- 支持128k上下文,约20%测试用例超出限制。不使用上下文管理仅51.4分。

- 工具使用

- 缩小闭源模型差距。通过上下文管理可进一步提升性能。

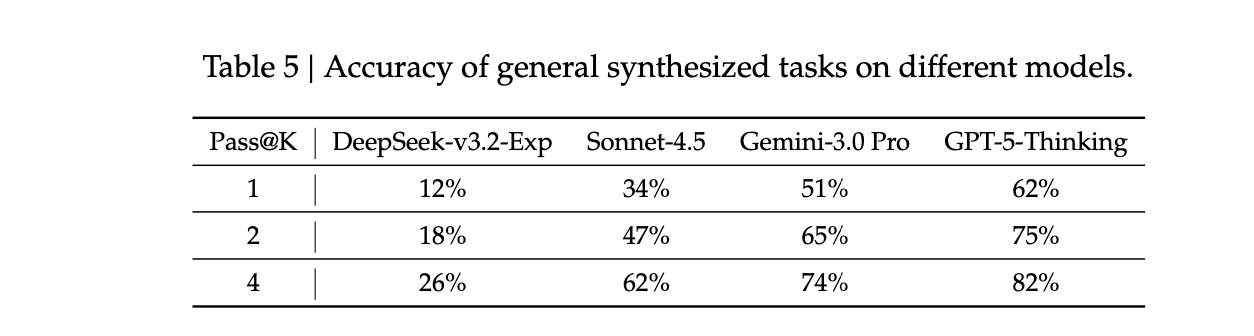

合成任务评估

- 合成任务对RL是否有挑战?

- 有挑战。DeepSeek-v3.2-Exp效果差,远低于GPT-5-Thinking最好。

- 合成任务泛化性如何,能否泛化到真实任务?

- 在DEepSeek-V3.2-SFT 做RL,在Tau2Bench/MCP-Mark/MCP-Universe都有提升。

- 对比实验:RL限制在纯Code和搜索场景,并不能提升这些Bench效果。

合成任务还是有难度:

未来方向

⛳ 未来方向

世界知识落后闭源模型:扩大预训练,弥补差距。Token效率提升:DeepSeekV3.2 需生成更长轨迹才能匹配Gemini3-pro效果。- 探索

更高效的测试时计算扩展策略(如并行搜索与串行思考的最佳组合)。

- 探索

复杂任务仍落后前沿模型:进一步完成基模和后训练流程。

(2510) DeepSeek-OCR

(2505) DeepSeek-R1-0528

(2502) Native Sparse Attention

- paper

- Native 稀疏注意力思想

- 使用

动态计算更紧凑的KV,保证稀疏性,解决了传统稀疏注意力实际效果不好的问题。 压缩块级粗粒度、选择保留细粒度、局部滑动注意力,3种注意力加权求和。

- 使用

问题背景:长度扩展依赖稀疏注意力

❓问题背景

llm长度很重要

长度很重要,但传统softmax注意力,时间复杂度随文本长度二次方增长,太高了不ok。- 如:解码64k长度,softmax注意力

占据70-80%时间

- 如:解码64k长度,softmax注意力

稀疏注意力可解

稀疏注意力:只选择与Q相关的少量Token,来计算Query-Key注意力。- 稀疏注意力笔记

稀疏注意力实际效果并不好

实际加速效果不好

不符合硬件计算逻辑,

内存访问不连续Sparse Attention 逻辑:减少FLOPS运算,随机、不规则访问内存。GPU 逻辑:并行计算。不匹配:导致

GPU大量在等待数据、找数据,而非计算,实际加速并不高。

只在推理特定阶段做加速

缺乏预训练/训推不一致

架构偏差/不一致:

预训练采用full、后训练/inference采用sparse- 模型

未充分学到Sparse,无法充分发挥sparse的潜力和优势

- 模型

使用稀疏注意力,需解决:

硬件对齐问题、训练感知问题。

稀疏注意力实际不高效的原因

1. 只在推理某个特定阶段做加速

H2O(2023):仅在decoding使用Sparse Attention- 在prefilling需要计算复杂的预处理,如注意力map/索引构建等操作。

MInference(2024):仅在prefilling使用Sparse Attention

2. 与主流解码架构MQA/GQA不兼容

MQA,GQA :

多个Q头共享1组 K-V头解码时非常高效,GPU只需从内存加载一小部分K和V。如Quest(2024)/Sparse:

每个Q头独立选择KV-Cache- 在MHA下,是稀疏的,但在GQA下

实际效果不理想需把Group内

所有Q头独立选的KV-Cache,都找出来做并集,作为GQA的KV虽然Sparse

减少计算操作,但需要的KV-Cache却仍然高。在解码阶段,内存访问非常高,

内存是瓶颈,最终导致实际加速效果不理想。

- 在MHA下,是稀疏的,但在GQA下

稀疏注意力训练存在挑战

1. 若不训练稀疏注意力,直接用效果不好

- 在

预训练好的Full Attention模型,直接应用稀疏注意力,会损害模型性能。

2. 若训练稀疏注意力,则存在挑战

某些稀疏操作不可微分,导致模型无法学习- 训练依赖梯度,某些

操作是离散的(A或B,无中间状态),导致梯度无法通过操作回传

- 训练依赖梯度,某些

- 某些操作尽管理论上可训练,但其

内存访问模式非常不规则,导致在GPU上训练效率很低- FlashAttention利用SRAM

把连续内存块加载进来进行计算。 - 但某些Sparse是

Token粒度的,可能会选择5、28、106这些不连续的token- GPU需要从内存的

各零散位置去读数据 大部分时间都在找数据、而非算数据,导致训练速度极慢。

- GPU需要从内存的

- FlashAttention利用SRAM

Native Sparse Attention

核心思想

📕核心方法

核心思想

- 对每个

, 不使用原始完整的KV,使用通过q和上下文kv动态计算出来的、更紧凑的KV 重新映射的KV总数,远小于原始总数,维持高稀疏性。

- 同时有

压缩、选择、滑动3种策略进行加权,权重由门控网络计算出来。

压缩+选择+滑动 注意力

压缩思想

- 通过将

连续的键值块聚合成块级表示,来捕获整个块的信息。 - 创建了

更紧凑、信息更密集的键值对 - 把

多个token进行压缩聚合

具体做法

- 将

K序列分成长度为l的块,每块之间有长度为d的滑动步长。 可学习的MLP与块内位置编码一起,将每个块中的Key映射到一个压缩Key。

优点

- 捕获

更粗粒度的高级语义信息,从而减少注意力机制的计算负担

缺点

- 可能

丢失细粒度信息

选择思想

选择性

保留细粒度token从历史信息中,

挑选最重要的几个信息快,来参与计算

具体做法

- 重要性分数

- NSA利用

压缩token的注意力计算产生的中间注意力分数来推导选择块的重要性分数。

- NSA利用

- Top-n 选择

- 按重要性分数排名,

保留top-n块中的token

- 按重要性分数排名,

优点

- 在降低计算复杂度的同时,

保留重要的细粒度信息,避免因过度压缩而损失关键细节。

目的

- 为了

防止局部模式过快适应并主导学习过程,从而阻碍模型从压缩和选择令牌中有效学习 - NSA引入了一个

专门的滑动窗口分支来显式处理局部上下文。

核心思想

- 处理局部信息的滑动窗口,只关注

最近一小段的历史信息

核心创新

NSA和硬件对齐

背景

- 稀疏注意力的

硬件不对齐问题,计算逻辑不同,导致实际加速和理论不匹配。

核心思想

- NSA 所有操作都是

基于block,使得内存访问变得很规整、连续,方便GPU。

端到端NSA训练

背景

- Sparse

缺乏预训练问题、训推不一致问题。

核心思想

- 端到端训练,模型

从预训练开始,就学会如何高效做信息压缩和筛选。 - 使得稀疏模式和模型本身就很匹配。

算法实验

✍️实验设置

模型

- 27B

预训练数据

- 260B tokens

架构

- Native Sparse Attention

评估Bench

- 通用评估

- 长上下文评估

- CoT 推理评估

🍑关键结果

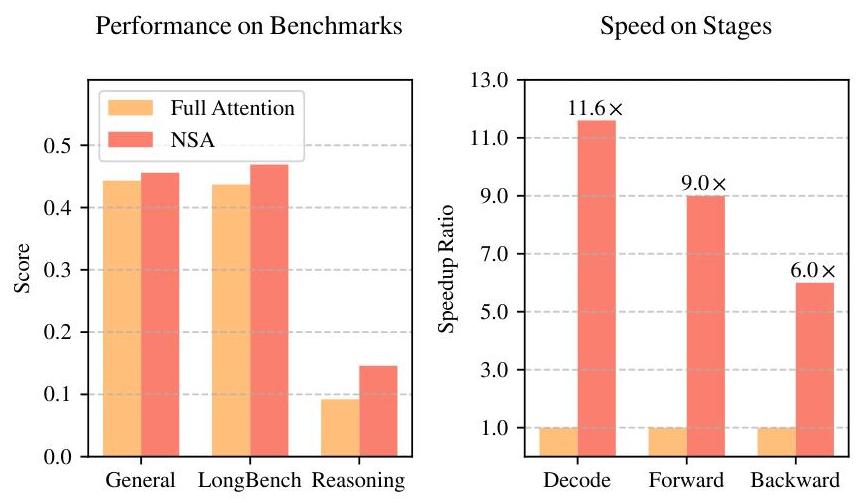

- 在通用、长上下文、CoT上,NSA和Full 效果差不多,但

提速达6-11倍。

计算效率

⛳未来方向

(2501) DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

- paper, 如何评价DeepSeek的R1与R1-Zero模型?, DeepSeek-R1 技术报告解读

- 纯rule-based强化学习DeepSeek-R1-Zero,四阶段训练的DeepSeek-R1,以及使用80w数据SFT蒸馏的小模型,效果都很好。

- 开创性作品,截止2507已达16w的论文引用😨。

问题背景

❓问题背景

- LLM在推理方向有进展,

但在复杂数学和科学上仍是重大挑战,开源界缺乏复制o1的明确路径。⚠️ - 之前推理相关方法存在问题 👿

- SFT方法:

高质量SFT推理数据成本高难以获取。 - RL方法:通常和SFT数据结合,

难以探索纯RL潜力。 - Test-Time Scaling:通过长度提升能力,但如何有效扩展,仍然是挑战。

- PRM:实际场景难以应用存在局限性

- MCTS搜索:效果有限。

- SFT方法:

核心方法

📕核心方法

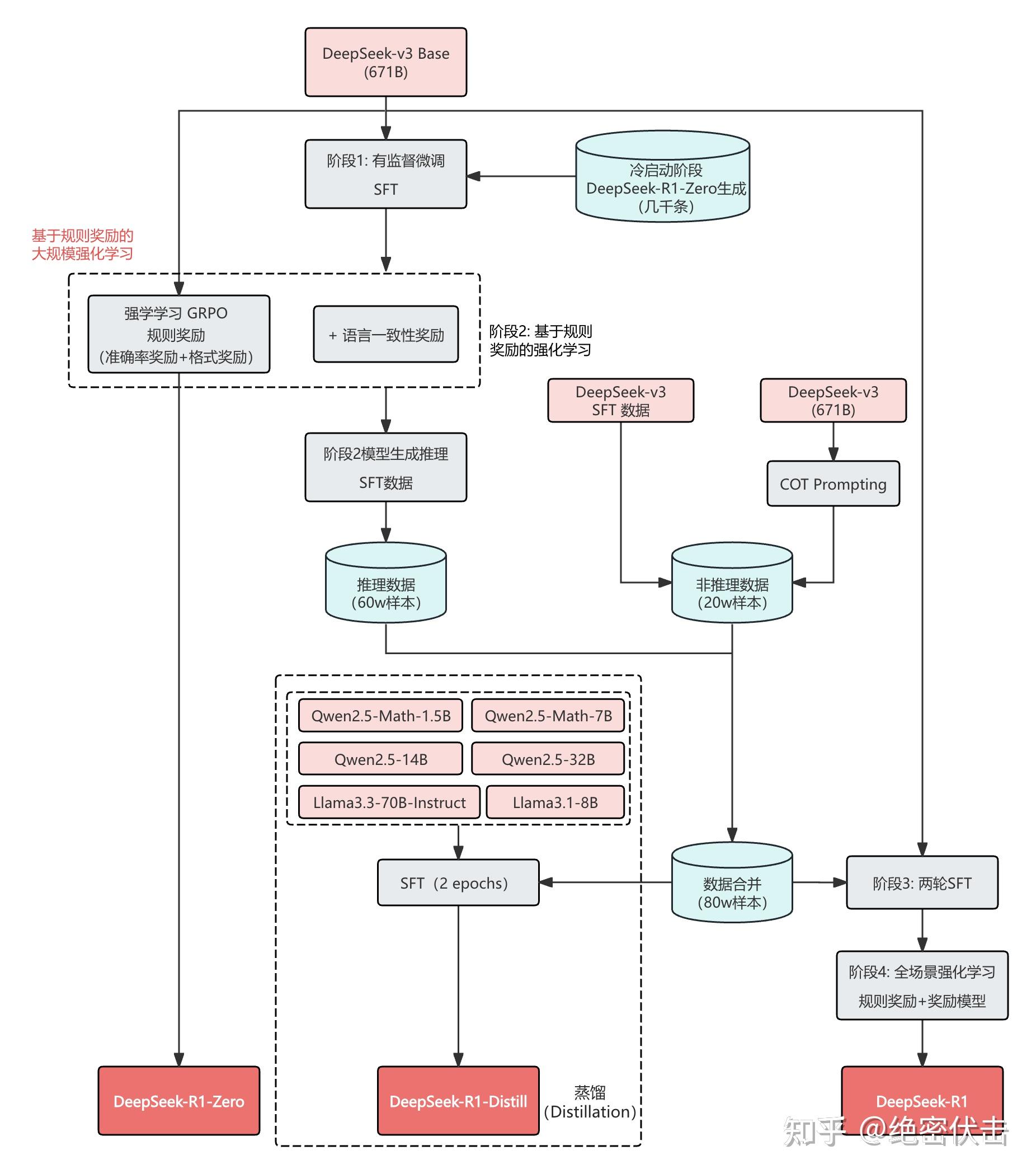

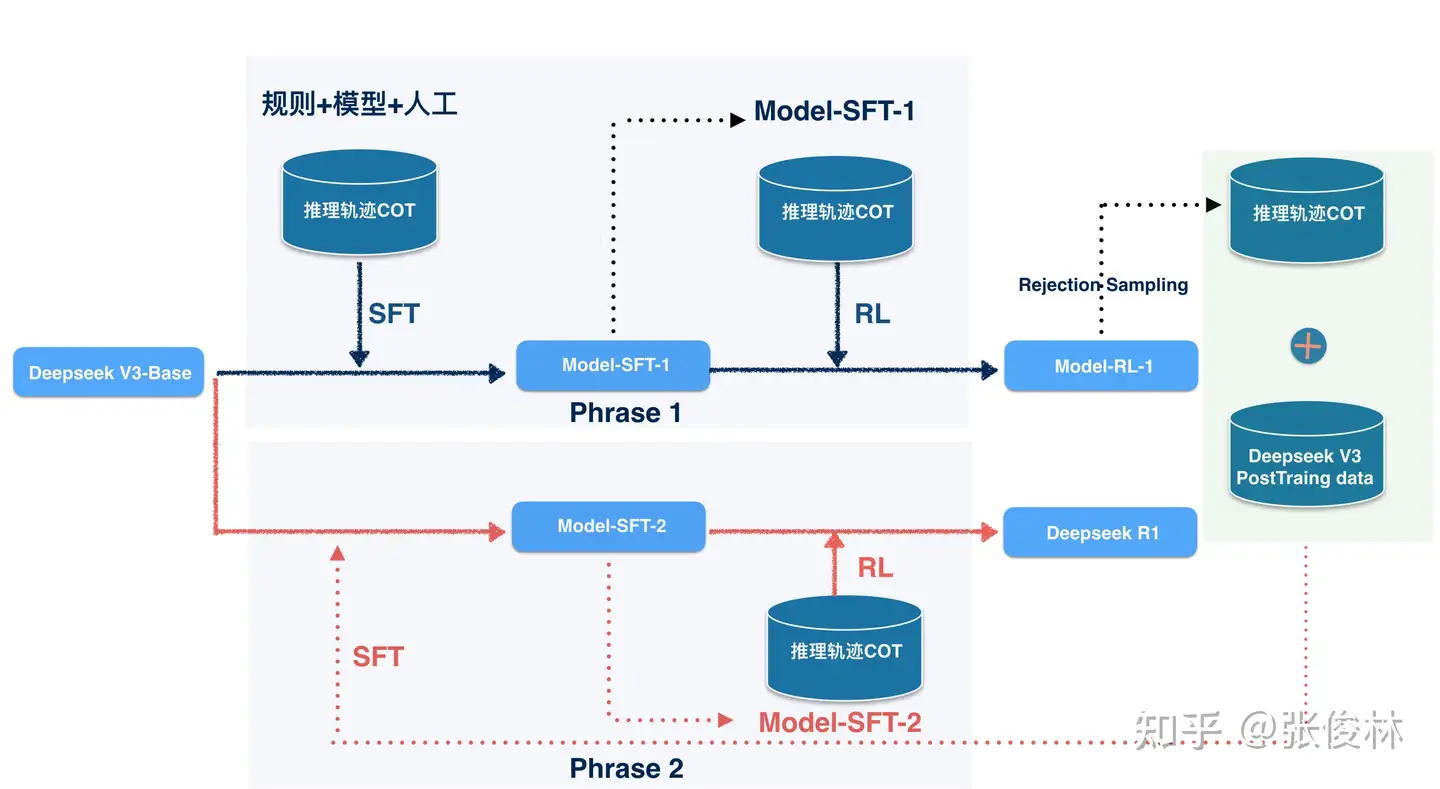

整体训练流程

- DeepSeek-R1-Zero:

纯强化学习 - DeepSeek-R1:

冷启动SFT->推理任务RL->Cot+通用数据SFT(80w)->全场景RL - 蒸馏小模型:

直接用80w数据做SFT

R1-Zero

⭐ 核心思想

- 核心方法:直接

基模+Rule-based RL,不使用SFT - Reward

- 准确率奖励:评估答案正确性,答案输出在

box中,数学/Code任务。 - 格式奖励:输出遵循格式,

<think>

- 准确率奖励:评估答案正确性,答案输出在

- 🔥GRPO算法

- 通过组内奖励来优化模型,无需critic model

采样一组输出并计算组内奖励均值和标准差来估计优势函数,来优化模型

- 训练模板

- 特定prompt,要求模型先生成推理过程,再输出最终答案,保证可解释性。

💥取得效果

- 数学评估:随RL推进,AIME24任务由15.6% -> 71%,媲美o1-0912

- 自我演化过程

- 输出长度不断增加,从几百到几千token,

- 模型自然获得解决复杂任务的能力,更深入探索和优化思维过程

- 顿悟时刻(AhaMoment)🤔

主动回溯、推翻先前想法并重新推理的行为。类似于人类恍然大悟。

💔缺点不足

- 可读性差、语言混合。

R1-多阶段训练方式

目标

- 解决R1-Zero中存在的语言混合/可读性差等问题。

训练一个人类友好、通用性强的模型。

🐱阶段1:冷启动

- 目的:

为了避免RL不稳定,让模型掌握基本CoT能力,更具输出可读性。 - 思想:RL之前,

使用小部分高质量CoT数据微调模型,作为最初RL Actor,使用DeepSeek-V3-base作为起点。 - 数据方法:

- Few-Shot Long Cot方法:让模型输出带反思和验证的答案

- 收集R1-Zero结果:进行人工修正优化

- 最终收集几千条数据📚

🐸阶段2:推理导向的强化学习

- 目的:

专注于推理任务做大规模强化学习,解决语言一致性问题 - 方法:在冷启动模型上,使用

代码/数学/科学/逻辑推理等数据(具有明确答案)做RL - 奖励设置

- 语言一致性:计算目标语言在CoT中的比例。

- 答案正确性:正确答案。

- 语言一致性:计算目标语言在CoT中的比例。

🐬阶段3:拒绝采样和SFT

- 目的:

提升模型在写作/问答/RolePlay等通用任务上的能力 - 方法:构建推理和非推理SFT数据,基于V3-Base做SFT。

- 推理数据构建(60w):

- 核心:用上阶段RL模型做

拒绝采样,每个推理样本生成多个轨迹,仅保留正确选项,构建高质量样本。 - ⭐评估筛选标准

- 规则判断:对于数学等容易判断的,使用rule进行判断。

- 模型判断:对于rule无法判断的,

用DeepSeekV3作为生成式RM,同时输入标准和模型答案,来判断是否正确。 - 可读性过滤:过滤难以阅读的样本,比如

语言混合、过长段落、过长代码片段等。

- 核心:用上阶段RL模型做

- 非推理数据构建(20w):

- 核心:使用Deepseek-v3的pipeline和部分v3的SFT数据。

- 方法:让v3在回答任务之前,先生成一些Cot;对于简单任务(如hello),则不需要Cot

- 训练:

使用80wSFT数据对V3-Base做了2轮SFT训练。

🐶阶段4:全场景下的强化学习

- 目的:

使模型在推理和非推理所有任务上表现良好,保证安全性和无害性 - 方法:在上阶段的SFT模型上进行RL训练。

小模型蒸馏

- 核心:使用80wSFT数据,直接对Qwen/LLaMA等小模型做SFT微调。

- 效果:显著提高了小模型的性能🚀,

在较小训练开销下取得远胜于自身RL学习的效果👍,展现出蒸馏技术的有效性。

算法实验

✍️实验设置

- 基准评测:

- 多种数学推理(AIME24/Math500)

- 代码题(LiveCodeBench/Codeforces)

- 知识问答(MMLU/GPQA/SimpleQA)

- 开放式场景(AlpacaEval2.0/ArenaHard)

- 蒸馏模型评测:AIME24/Math500/GPQA/Codeforces/LiveCodeBench。

- 参数设置:最大生成长度32k,temperature=0.6, top-p=0.95,每次生成64回答以估计pass@1

🍑关键结果

- DeepSeekR1 效果好

- 教育知识Bench效果好相比V3提升显著(MMLU-Pro/GPQA等)

- 指令遵循能力强(IF-Eval),摘要简洁长度偏差小

- 数学推理能力和o1持平,远超其他模型

- 蒸馏模型效果好

- R1-Qwen-7B所有方法超过GPT4o-0523,R1-14B全面超越QwQ-32B-Preview,R1-32B和R1-70B大多数都优于o1-mini

未来方向

⛳未来方向